Слайд 2

М. В . Ломоносов:

«Математику уже затем учить

следует, что она ум в порядок приводит».

Давид Гильберт:

«Математика –

основа всего точного естествознания».

Теория вероятностей (ТВ) и математическая статистика (МС) – это ветви математики.

Слайд 3

Повесьте ваши уши на гвоздь внимания !!!!!!

Слайд 4

Раздел 1.

Теория вероятностей

Введение.

Теория вероятностей – это математическая наука,

изучающая закономерности случайных событий.

Математическая статистика – это наука об

обработке больших массивов информации и получении практически значимых выводов на основе этой обработки.

Случайные события – это события (явления), которые могут произойти, а могут и не произойти.

Слайд 5

Примеры неслучайных событий: рождение – смерть, прилив –

отлив, восход и закат солнца.

Становление теории вероятностей относится к

эпохе Возрождения в Италии (15 век):

итальянец Кардано (16 век) – «Книга об игре в кости»;

Галилео Галилей (1564-1642) – «О выходе очков при игре в кости».

Считается, что теория вероятностей зародилась как наука в переписке двух ученых Б. Паскаля (1623г.-1662г.) и П. Ферма (1601г.-1665г.);

Якоб Бернулли, который в 1713г. выпустил книгу «Искусство предположений»;

Колмогоров Андрей Николаевич (1903г.-1987г.) - год 1933 – аксиоматическое построение теории вероятностей..

Слайд 6

§ 1. Случайный эксперимент. Элементарные исходы случайного эксперимента.

Случайное событие.

Реализация случайного события возможна в ходе случайного эксперимента

(иначе: случайного опыта). Например, нас интересует событие «Выпадение герба при бросании монеты». Но для возможности возникновения этого события следует произвести опыт, состоящий в бросании монеты.

Совокупность всех условий, при которых возможна реализация случайного события, носит название случайного эксперимента или случайного опыта.

События обозначаем заглавными латинскими буквами: А, В, С, D,…

Слайд 7

Некоторые из случайных событий можно разбить на более

простые события.

Те события, которые нельзя разбить на другие

более простые события, называются элементарными событиями или элементарными исходами случайного эксперимента.

Совокупность всех элементарных исходов эксперимента носит название «множество (или пространство) всех элементарных исходов случайного эксперимента».

Обозначение: Ω = { ω1, ω2, … , ωn}

Мы будем рассматривать задачи с элементарными исходами, которые являются равновозможными.

Не всегда число элементарных исходов конечно, т. е. Ω может состоять из бесконечного числа исходов.

Те элементарные исходы, при которых реализуется событие А, называются элементарными исходами, благоприятствующими наступлению событию А или просто благоприятными исходами.

Слайд 8

§ 2. Классификация случайных событий

Достоверное событие

– это событие, которое обязательно произойдёт в данном случайном

эксперименте.

Обозначается символом Ω (поскольку включает все возможные элементарные исходы такого случайного эксперимента).

Невозможное событие – такое событие, которое никогда не произойдёт в данном случайном эксперименте.

Противоположное событие - это событие, состоящее в ненаступлении события А.

События удобно изображать, используя множество точек на плоскости. Для этого используются диаграммы Эйлера - Венна (иногда – диаграммы Венна).

События А и В называются несовместными, если они не могут произойти одновременно в одном и том же случайном эксперименте.

События А и В называются совместными, если они могут произойти одновременно в одном и том же случайном эксперименте.

Слайд 9

§3. Действия над событиями (исчисление событий)

Объединением двух событий

AUB или суммой двух событий (A+B) называется новое событие,

которое заключается в наступлении хотя бы одного из событий A или B (наступает либо событие A, либо событие B, либо то и другое одновременно).

Обобщение: Объединением нескольких событий называется событие, состоящее в одновременном наступлении хотя бы одного из данных событий.

Пересечением двух событий А∩В (или АВ) называется новое событие, состоящее в одновременном наступлении этих двух событий.

Слайд 10

Обобщение: Пересечением нескольких событий

называется новое событие, состоящее в одновременном наступлении всех этих

событий.

Рассмотрены свойства операций объединения и пересечения событий, которые частично совпадают со свойствами операций сложения и умножения чисел, но не всегда. На основе этих свойств в дальнейшем из простых случайных событий формируются более сложные случайные события.

Слайд 11

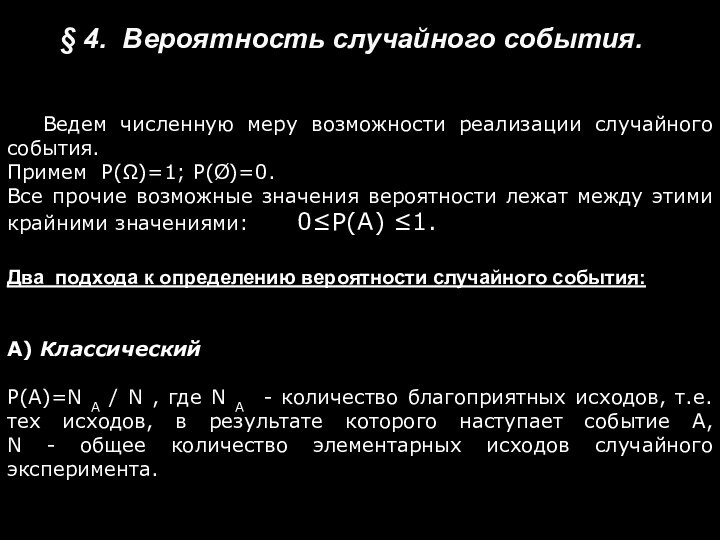

§ 4. Вероятность случайного события.

Ведем численную меру возможности

реализации случайного события.

Примем Р(Ω)=1; Р(Ø)=0.

Все прочие возможные значения вероятности

лежат между этими крайними значениями: 0≤Р(А) ≤1.

Два подхода к определению вероятности случайного события:

А) Классический

Р(А)=N A / N , где N A - количество благоприятных исходов, т.е. тех исходов, в результате которого наступает событие А, N - общее количество элементарных исходов случайного эксперимента.

Слайд 12

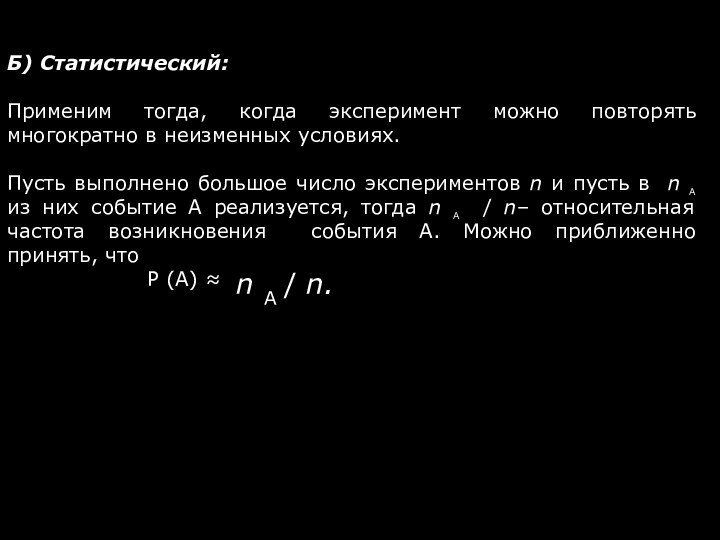

Б) Статистический:

Применим тогда, когда эксперимент можно повторять многократно

в неизменных условиях.

Пусть выполнено большое число экспериментов n и

пусть в n a из них событие А реализуется, тогда n a / n– относительная частота возникновения события A. Можно приближенно принять, что

Р (A) ≈

n A / n.

Слайд 13

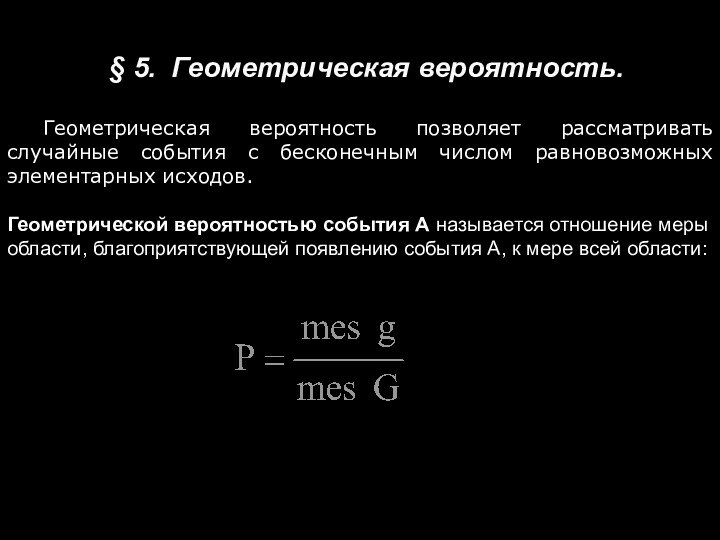

§ 5. Геометрическая вероятность.

Геометрическая вероятность позволяет рассматривать

случайные события с бесконечным числом равновозможных элементарных исходов.

Геометрической вероятностью

события А называется отношение меры области, благоприятствующей появлению события А, к мере всей области:

Слайд 14

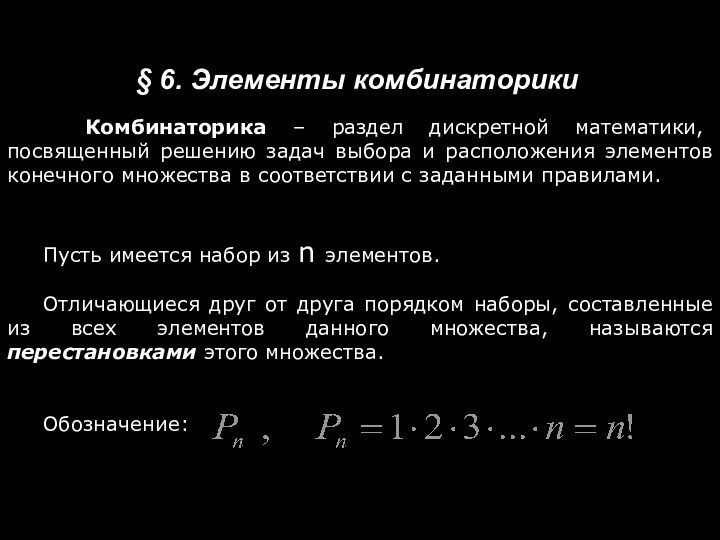

Комбинаторика – раздел дискретной математики, посвященный решению

задач выбора и расположения элементов конечного множества в соответствии

с заданными правилами.

§ 6. Элементы комбинаторики

Пусть имеется набор из n элементов.

Отличающиеся друг от друга порядком наборы, составленные из всех элементов данного множества, называются перестановками этого множества.

Обозначение:

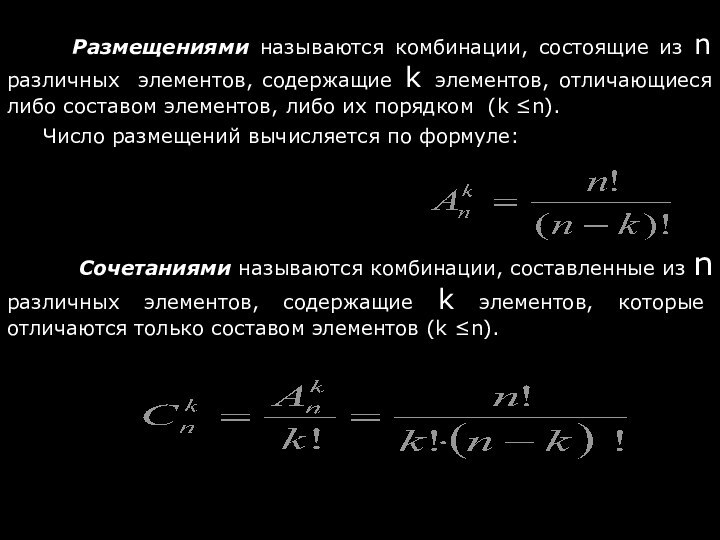

Слайд 15

Размещениями называются комбинации, состоящие из n

различных элементов, содержащие k элементов, отличающиеся либо

составом элементов, либо их порядком (k ≤n).

Число размещений вычисляется по формуле:

Сочетаниями называются комбинации, составленные из n различных элементов, содержащие k элементов, которые отличаются только составом элементов (k ≤n).

Слайд 16

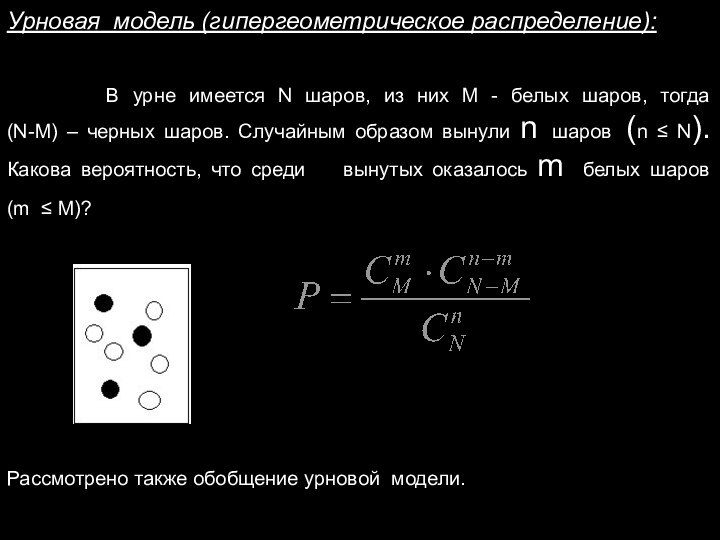

Урновая модель (гипергеометрическое распределение):

В

урне имеется N шаров, из них М - белых

шаров, тогда (N-М) – черных шаров. Случайным образом вынули n шаров (n ≤ N). Какова вероятность, что среди вынутых оказалось m белых шаров (m ≤ M)?

Рассмотрено также обобщение урновой модели.

Слайд 17

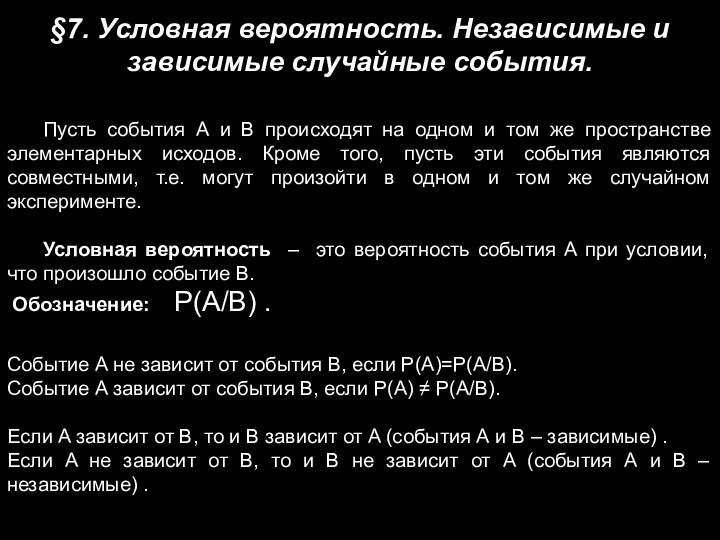

§7. Условная вероятность. Независимые и зависимые случайные события.

Пусть

события А и В происходят на одном и том

же пространстве элементарных исходов. Кроме того, пусть эти события являются совместными, т.е. могут произойти в одном и том же случайном эксперименте.

Условная вероятность – это вероятность события A при условии, что произошло событие B.

Обозначение: P(A/B) .

Событие A не зависит от события B, если P(A)=P(A/B).

Событие A зависит от события B, если P(A) ≠ P(A/B).

Если A зависит от B, то и B зависит от A (события А и В – зависимые) .

Если A не зависит от B, то и B не зависит от A (события А и В – независимые) .

Слайд 18

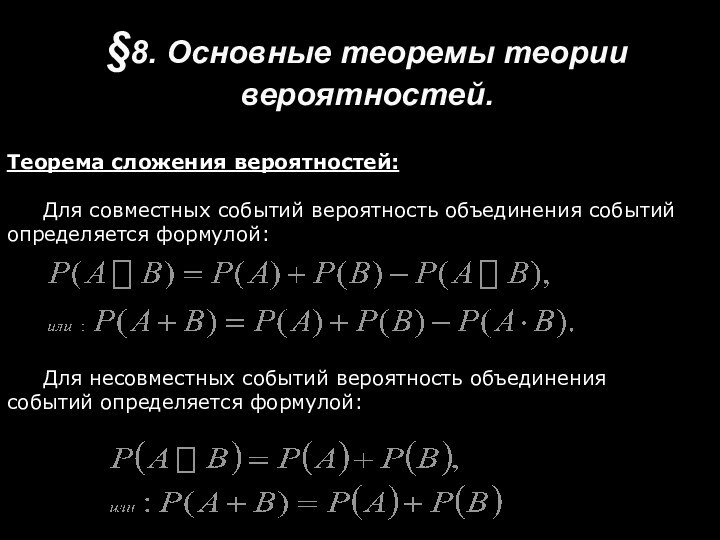

§8. Основные теоремы теории вероятностей.

Теорема сложения вероятностей:

Для совместных

событий вероятность объединения событий определяется формулой:

Для несовместных событий вероятность

объединения событий определяется формулой:

Слайд 19

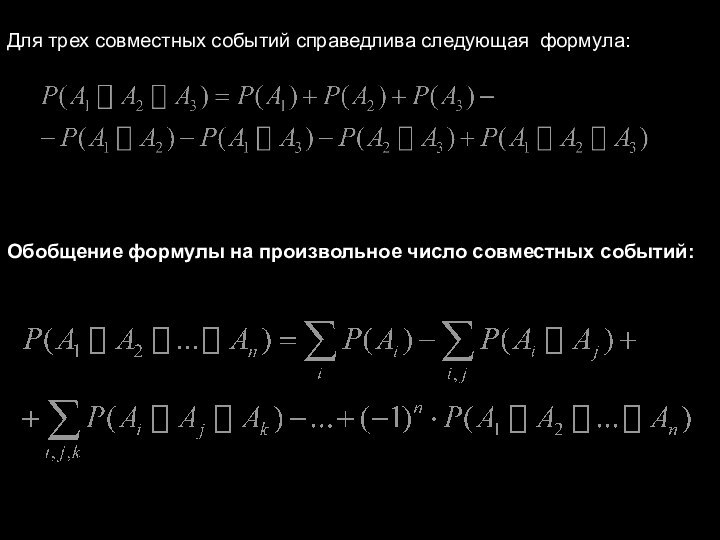

Для трех совместных событий справедлива следующая формула:

Обобщение формулы

на произвольное число совместных событий:

Слайд 20

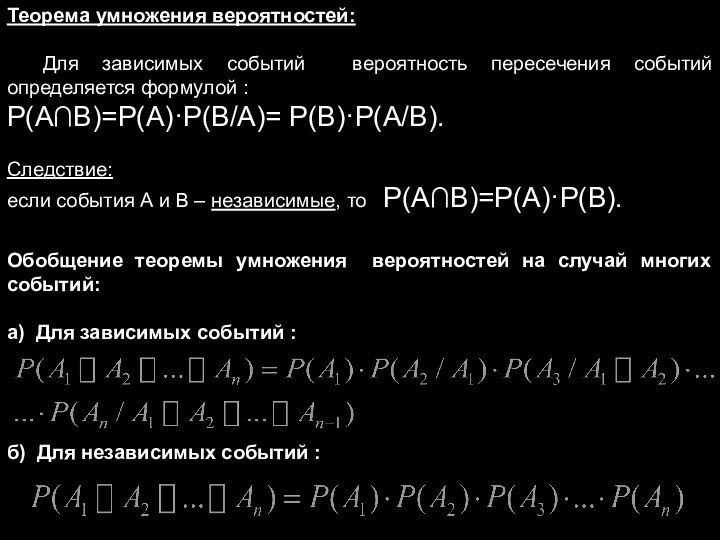

Теорема умножения вероятностей:

Для зависимых событий вероятность пересечения событий

определяется формулой :

Р(А∩В)=Р(А)·Р(В/А)= Р(В)·Р(А/В).

Следствие:

если события А и В –

независимые, то Р(А∩В)=Р(А)·Р(В).

Обобщение теоремы умножения вероятностей на случай многих событий:

а) Для зависимых событий :

б) Для независимых событий :

Слайд 21

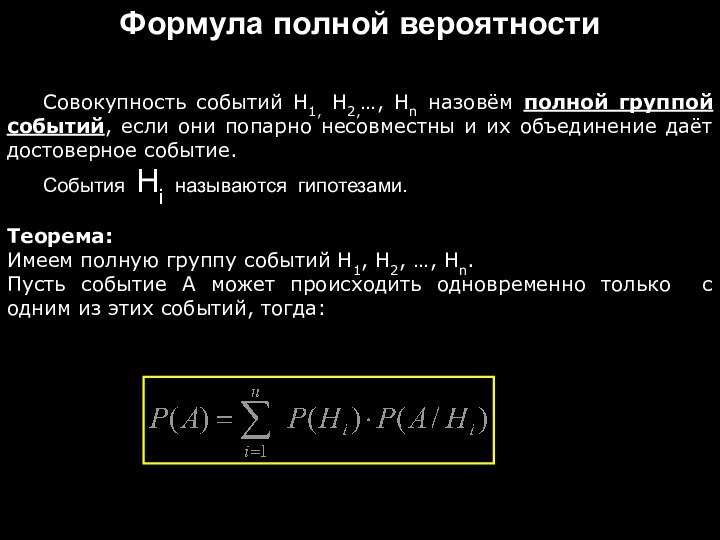

Формула полной вероятности

Совокупность событий Н1, Н2,…, Нn назовём

полной группой событий, если они попарно несовместны и их

объединение даёт достоверное событие.

События Нi называются гипотезами.

Теорема:

Имеем полную группу событий Н1, Н2, …, Нn.

Пусть событие А может происходить одновременно только с одним из этих событий, тогда:

Слайд 22

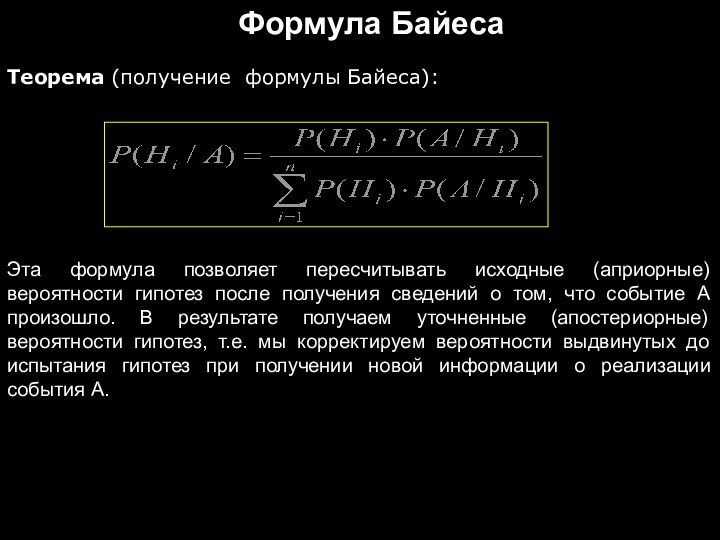

Формула Байеса

Теорема (получение формулы Байеса):

Эта формула позволяет пересчитывать

исходные (априорные) вероятности гипотез после получения сведений о том,

что событие А произошло. В результате получаем уточненные (апостериорные) вероятности гипотез, т.е. мы корректируем вероятности выдвинутых до испытания гипотез при получении новой информации о реализации события А.

Слайд 23

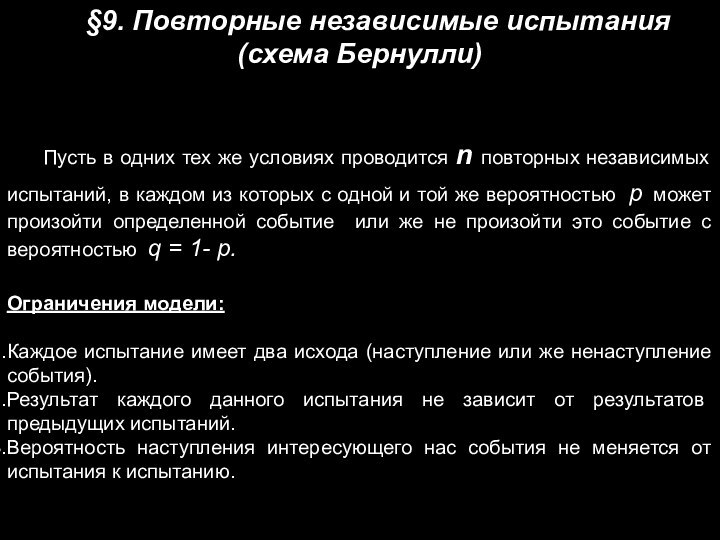

§9. Повторные независимые испытания (схема Бернулли)

Пусть в одних

тех же условиях проводится n повторных независимых испытаний, в

каждом из которых с одной и той же вероятностью р может произойти определенной событие или же не произойти это событие с вероятностью q = 1- p.

Ограничения модели:

Каждое испытание имеет два исхода (наступление или же ненаступление события).

Результат каждого данного испытания не зависит от результатов предыдущих испытаний.

Вероятность наступления интересующего нас события не меняется от испытания к испытанию.

Слайд 24

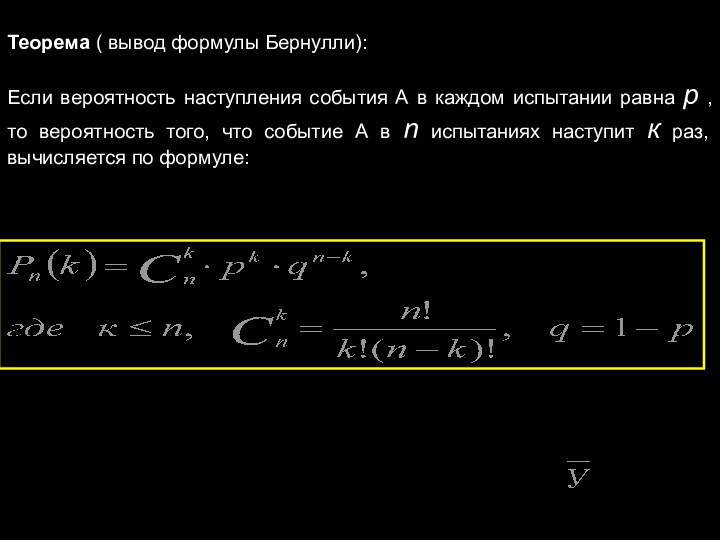

Теорема ( вывод формулы Бернулли):

Если вероятность наступления события

А в каждом испытании равна р , то вероятность

того, что событие А в n испытаниях наступит к раз, вычисляется по формуле:

Слайд 25

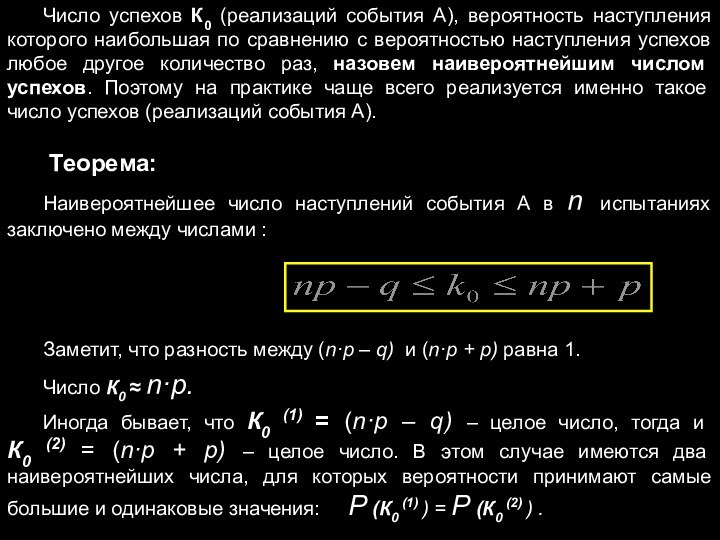

Число успехов К0 (реализаций события А), вероятность наступления

которого наибольшая по сравнению с вероятностью наступления успехов любое

другое количество раз, назовем наивероятнейшим числом успехов. Поэтому на практике чаще всего реализуется именно такое число успехов (реализаций события А).

Теорема:

Наивероятнейшее число наступлений события А в n испытаниях заключено между числами :

Заметит, что разность между (n·p – q) и (n·p + p) равна 1.

Число К0 ≈ n·p.

Иногда бывает, что К0 (1) = (n·p – q) – целое число, тогда и К0 (2) = (n·p + р) – целое число. В этом случае имеются два наивероятнейших числа, для которых вероятности принимают самые большие и одинаковые значения: Р (К0 (1) ) = Р (К0 (2) ) .

Слайд 26

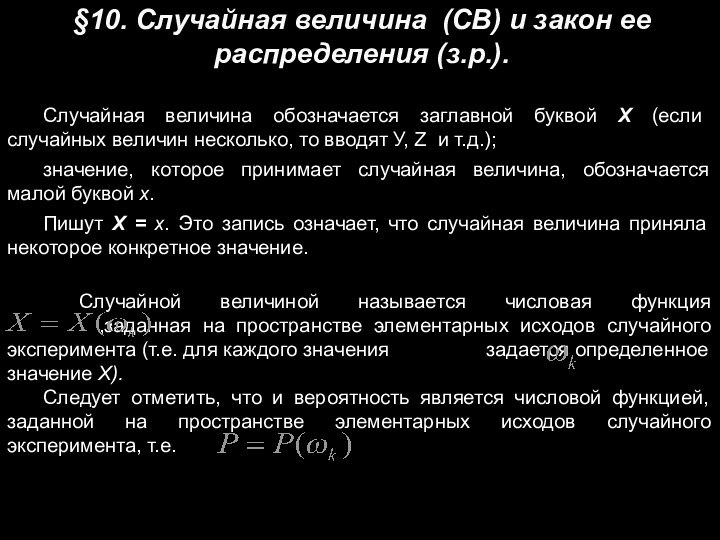

§10. Случайная величина (СВ) и закон ее распределения

(з.р.).

Случайная величина обозначается заглавной буквой Х (если случайных величин

несколько, то вводят У, Z и т.д.);

значение, которое принимает случайная величина, обозначается малой буквой х.

Пишут Х = х. Это запись означает, что случайная величина приняла некоторое конкретное значение.

Случайной величиной называется числовая функция ,заданная на пространстве элементарных исходов случайного эксперимента (т.е. для каждого значения задается определенное значение Х).

Следует отметить, что и вероятность является числовой функцией, заданной на пространстве элементарных исходов случайного эксперимента, т.е.

Слайд 27

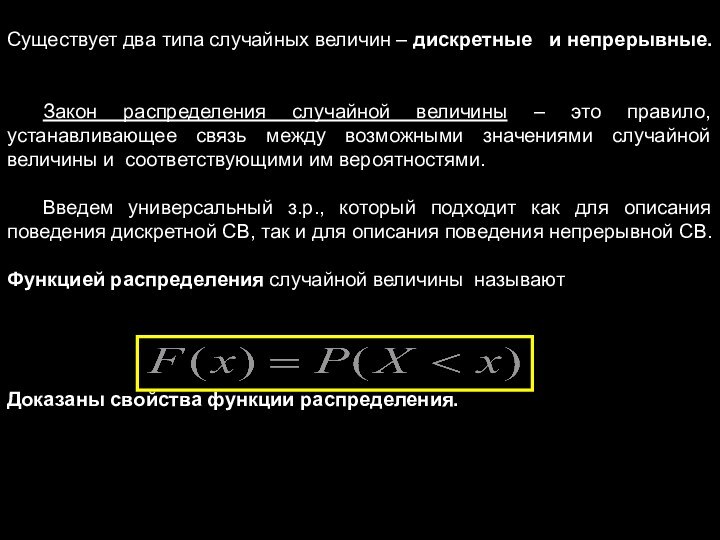

Существует два типа случайных величин – дискретные

и непрерывные.

Закон распределения случайной величины – это правило,

устанавливающее связь между возможными значениями случайной величины и соответствующими им вероятностями.

Введем универсальный з.р., который подходит как для описания поведения дискретной СВ, так и для описания поведения непрерывной СВ.

Функцией распределения случайной величины называют

Доказаны свойства функции распределения.

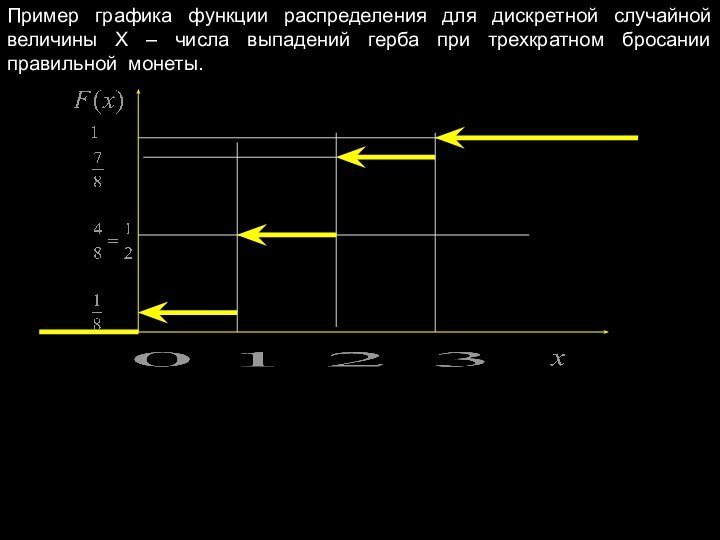

Слайд 28

Пример графика функции распределения для дискретной случайной величины

Х – числа выпадений герба при трехкратном бросании правильной

монеты.

Слайд 29

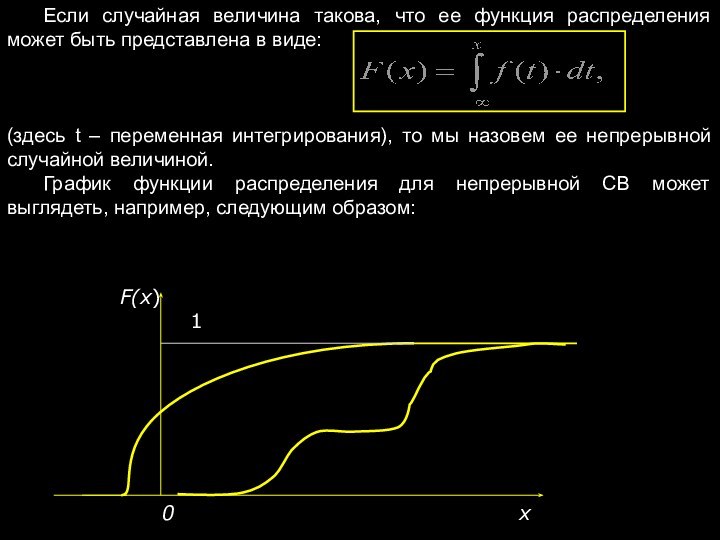

Если случайная величина такова, что ее функция распределения

может быть представлена в виде:

(здесь t – переменная

интегрирования), то мы назовем ее непрерывной случайной величиной.

График функции распределения для непрерывной СВ может выглядеть, например, следующим образом:

F(x)

1

0 x

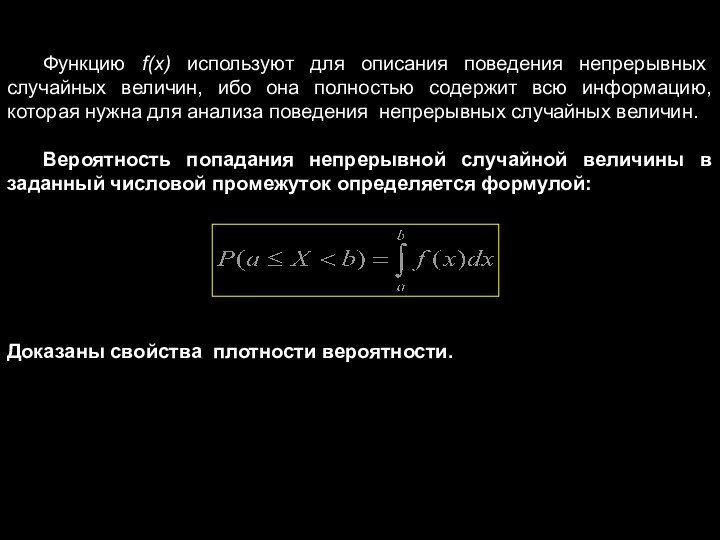

Слайд 30

Функцию f(x) используют для описания поведения непрерывных случайных

величин, ибо она полностью содержит всю информацию, которая нужна

для анализа поведения непрерывных случайных величин.

Вероятность попадания непрерывной случайной величины в заданный числовой промежуток определяется формулой:

Доказаны свойства плотности вероятности.

Слайд 31

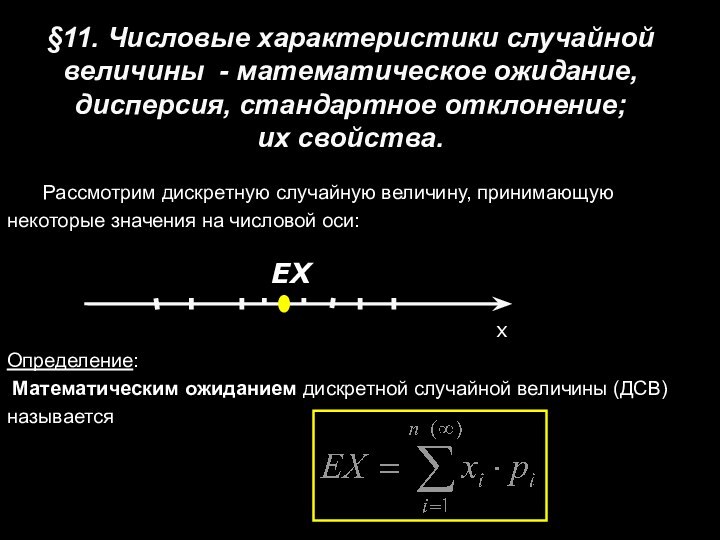

§11. Числовые характеристики случайной величины - математическое ожидание,

дисперсия, стандартное отклонение;

их свойства.

Рассмотрим дискретную случайную величину, принимающую

некоторые значения на числовой оси:

Определение:

Математическим ожиданием дискретной случайной величины (ДСВ)

называется

Слайд 32

Для случая n→ ∞ ряд должен

быть сходящимся. Возникают иногда ситуации, когда ряд расходится. Тогда

случайная величина не имеет математического ожидания. Такие случай мы рассматривать не будем.

Статистический смысл математического ожидания:

Вычисляя среднее арифметическое всех наблюдаемых значений СВ, получают математическое ожидание СВ в практических задачах.

Слайд 33

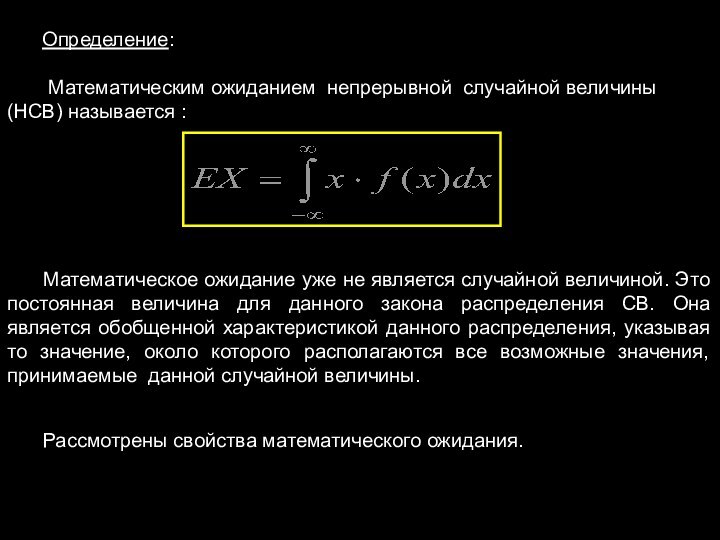

Определение:

Математическим ожиданием непрерывной случайной величины (НСВ) называется

:

Математическое ожидание уже не является случайной величиной. Это постоянная

величина для данного закона распределения СВ. Она является обобщенной характеристикой данного распределения, указывая то значение, около которого располагаются все возможные значения, принимаемые данной случайной величины.

Рассмотрены свойства математического ожидания.

Слайд 34

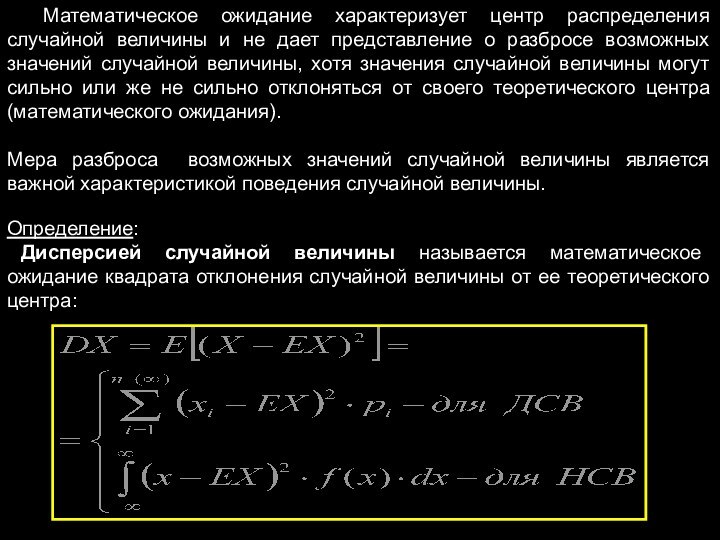

Математическое ожидание характеризует центр распределения случайной величины и

не дает представление о разбросе возможных значений случайной величины,

хотя значения случайной величины могут сильно или же не сильно отклоняться от своего теоретического центра (математического ожидания).

Мера разброса возможных значений случайной величины является важной характеристикой поведения случайной величины.

Определение:

Дисперсией случайной величины называется математическое ожидание квадрата отклонения случайной величины от ее теоретического центра:

Слайд 35

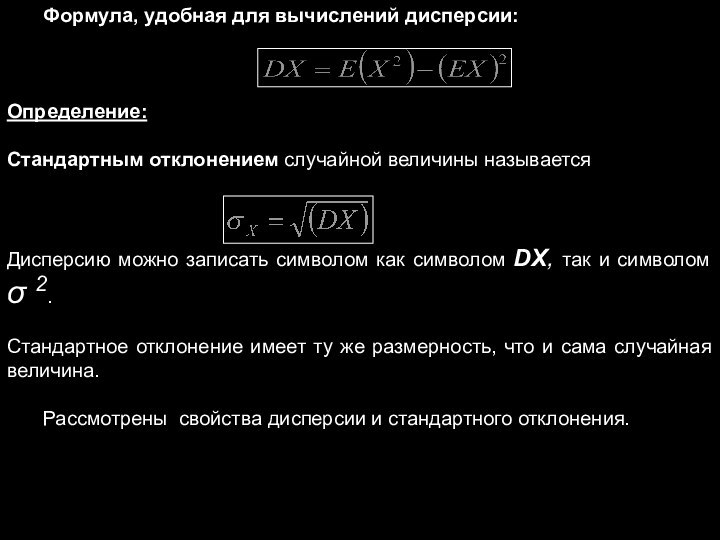

Формула, удобная для вычислений дисперсии:

Определение:

Стандартным отклонением случайной величины

называется

Дисперсию можно записать символом как символом DX, так и

символом σ 2.

Стандартное отклонение имеет ту же размерность, что и сама случайная величина.

Рассмотрены свойства дисперсии и стандартного отклонения.

Слайд 36

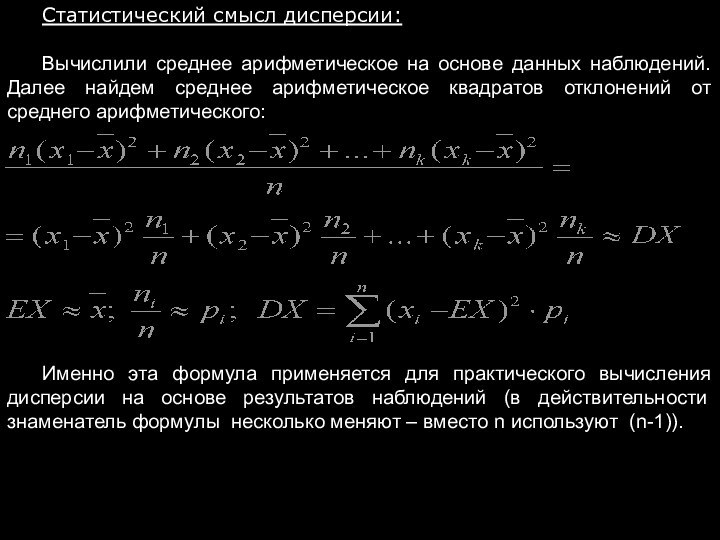

Статистический смысл дисперсии:

Вычислили среднее арифметическое на основе данных

наблюдений. Далее найдем среднее арифметическое квадратов отклонений от среднего

арифметического:

Именно эта формула применяется для практического вычисления дисперсии на основе результатов наблюдений (в действительности знаменатель формулы несколько меняют – вместо n используют (n-1)).

Слайд 37

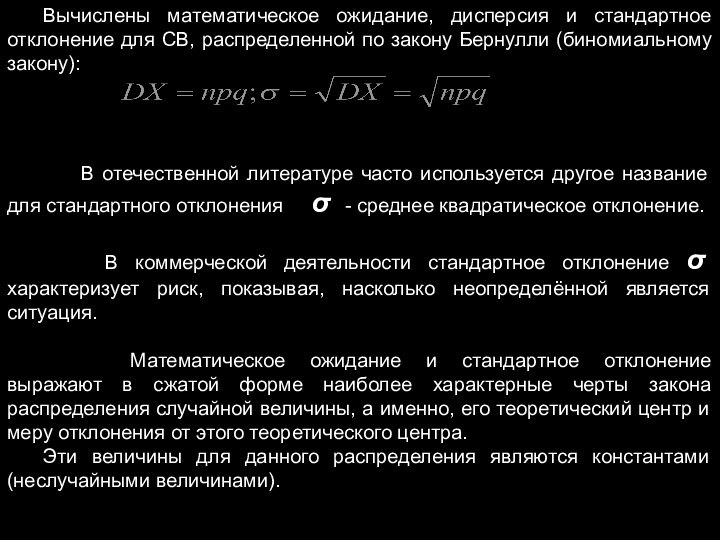

Вычислены математическое ожидание, дисперсия и стандартное отклонение для

СВ, распределенной по закону Бернулли (биномиальному закону):

В отечественной литературе часто используется другое название для стандартного отклонения σ - среднее квадратическое отклонение.

В коммерческой деятельности стандартное отклонение σ характеризует риск, показывая, насколько неопределённой является ситуация.

Математическое ожидание и стандартное отклонение выражают в сжатой форме наиболее характерные черты закона распределения случайной величины, а именно, его теоретический центр и меру отклонения от этого теоретического центра.

Эти величины для данного распределения являются константами (неслучайными величинами).

Слайд 38

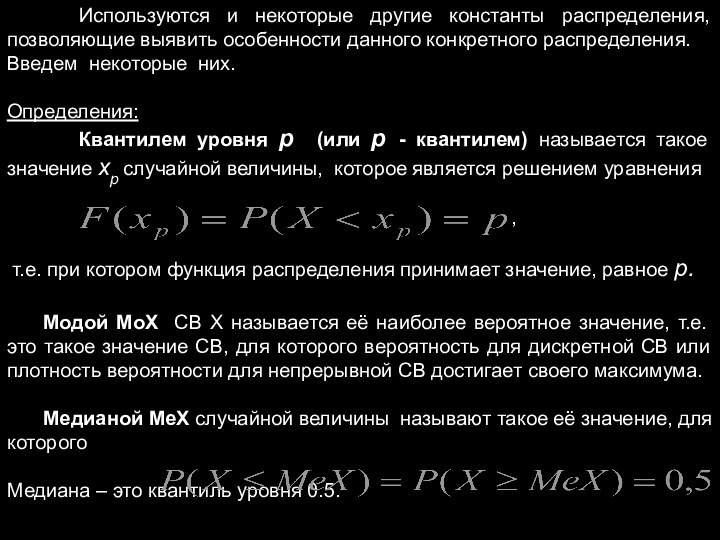

Используются и некоторые другие константы распределения, позволяющие выявить

особенности данного конкретного распределения.

Введем некоторые них.

Определения:

Квантилем уровня р

(или р - квантилем) называется такое значение хр случайной величины, которое является решением уравнения

,

т.е. при котором функция распределения принимает значение, равное р.

Модой MоX СВ X называется её наиболее вероятное значение, т.е. это такое значение СВ, для которого вероятность для дискретной СВ или плотность вероятности для непрерывной СВ достигает своего максимума.

Медианой МеХ случайной величины называют такое её значение, для которого

Медиана – это квантиль уровня 0.5.

Слайд 39

§ 12. Наиболее часто используемые законы распределения случайных

величин.

Дискретные случайные величины:

Для ДСВ наиболее часто используется биномиальный закон

распределения.

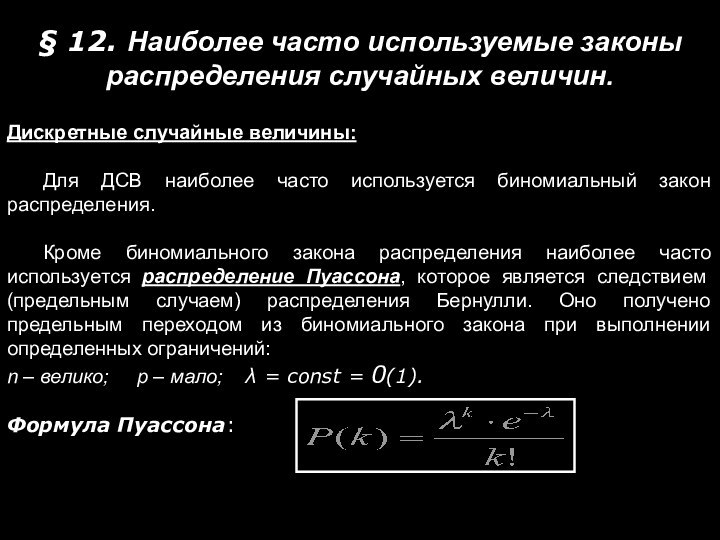

Кроме биномиального закона распределения наиболее часто используется распределение Пуассона, которое является следствием (предельным случаем) распределения Бернулли. Оно получено предельным переходом из биномиального закона при выполнении определенных ограничений:

n – велико; p – мало; λ = const = 0(1).

Формула Пуассона:

Слайд 40

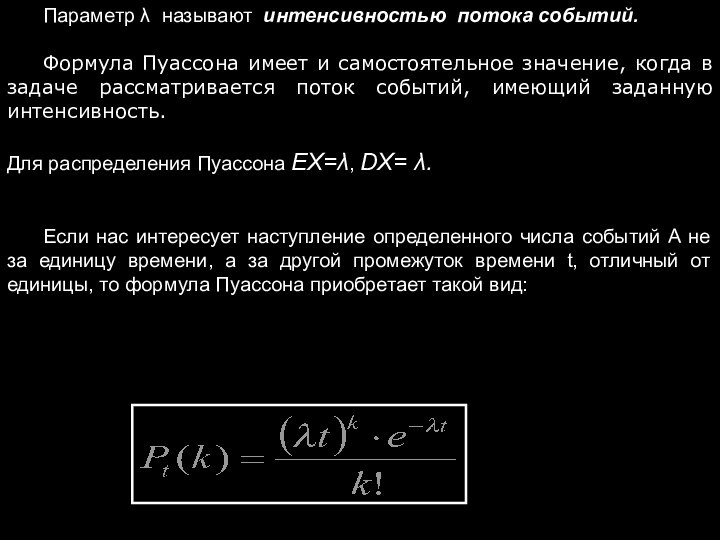

Параметр λ называют интенсивностью потока событий.

Формула Пуассона имеет

и самостоятельное значение, когда в задаче рассматривается поток событий,

имеющий заданную интенсивность.

Для распределения Пуассона EX=λ, DX= λ.

Если нас интересует наступление определенного числа событий А не за единицу времени, а за другой промежуток времени t, отличный от единицы, то формула Пуассона приобретает такой вид:

Слайд 41

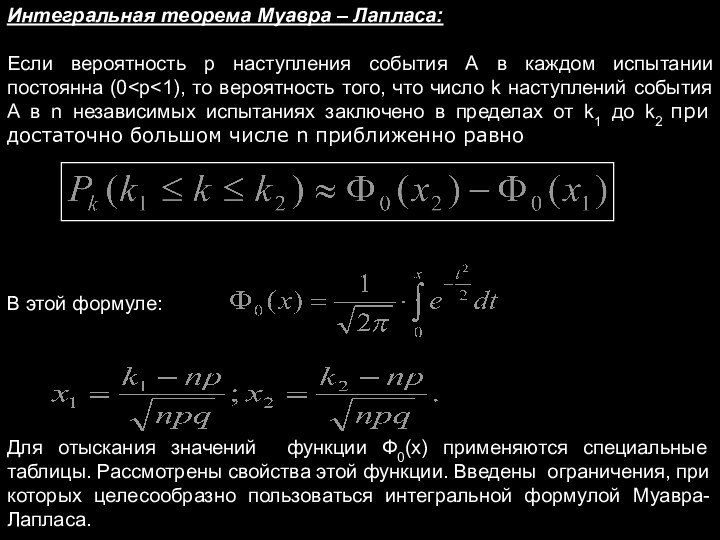

Интегральная теорема Муавра – Лапласа:

Если вероятность p наступления

события А в каждом испытании постоянна (0

того, что число k наступлений события А в n независимых испытаниях заключено в пределах от k1 до k2 при достаточно большом числе n приближенно равно

В этой формуле:

Для отыскания значений функции Ф0(х) применяются специальные таблицы. Рассмотрены свойства этой функции. Введены ограничения, при которых целесообразно пользоваться интегральной формулой Муавра-Лапласа.

Слайд 42

Непрерывные случайные величины:

СВ Х имеет равномерный закон распределения

на отрезке [a, b], если ее плотность распределения постоянна

на этом отрезке и равна нулю вне его:

Слайд 43

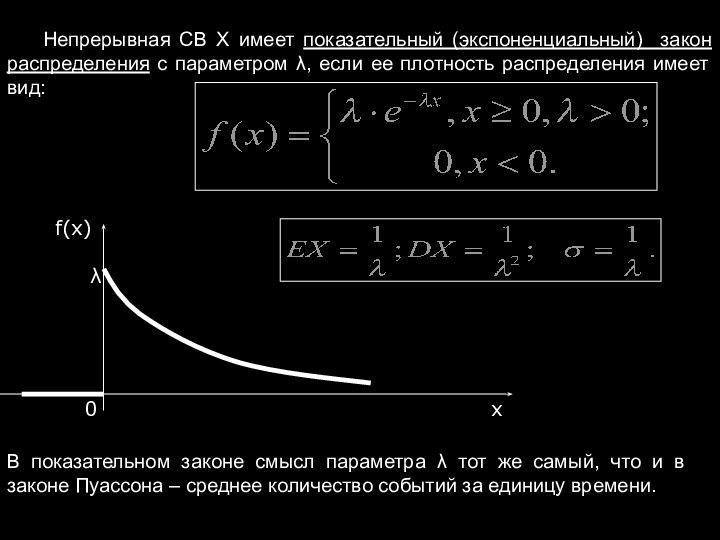

Непрерывная СВ Х имеет показательный (экспоненциальный) закон распределения

с параметром λ, если ее плотность распределения имеет вид:

В показательном законе смысл параметра λ тот же самый, что и в законе Пуассона – среднее количество событий за единицу времени.

Слайд 44

Между законами распределения Пуассона и показательным существует тесная

связь:

Количество событий за любой фиксированный промежуток времени имеет распределение

Пуассона, а время ожидания между событиями - показательное распределение.

Поток событий, для описания которого справедливы упомянутые распределения, должен быть подчинен определенным ограничениям для того, чтобы его поведение можно было описать такими простыми формулами.

Эти ограничения потока событий таковы:

Стационарность (интенсивность потока событий λ не зависит от времени);

Отсутствие последействия (количество событий, попадающих на данный промежуток времени, не зависит от числа событий, попадающих на другой промежуток времени, не пересекающийся с данным);

Ординарность (вероятность попадания на малый промежуток времени двух или более событий пренебрежимо мала по сравнению с вероятностью попадания на этот же малый промежуток времени одного события).

Слайд 45

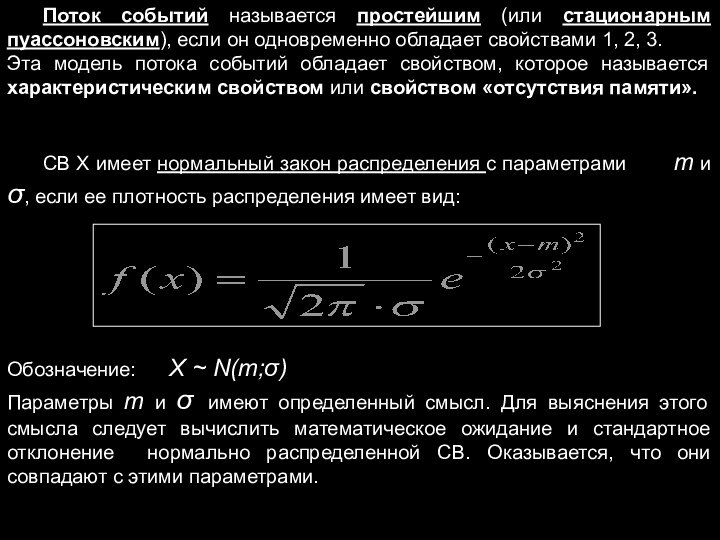

Поток событий называется простейшим (или стационарным пуассоновским), если

он одновременно обладает свойствами 1, 2, 3.

Эта модель

потока событий обладает свойством, которое называется характеристическим свойством или свойством «отсутствия памяти».

СВ Х имеет нормальный закон распределения с параметрами m и σ, если ее плотность распределения имеет вид:

Обозначение: X ~ N(m;σ)

Параметры m и σ имеют определенный смысл. Для выяснения этого смысла следует вычислить математическое ожидание и стандартное отклонение нормально распределенной СВ. Оказывается, что они совпадают с этими параметрами.

Слайд 46

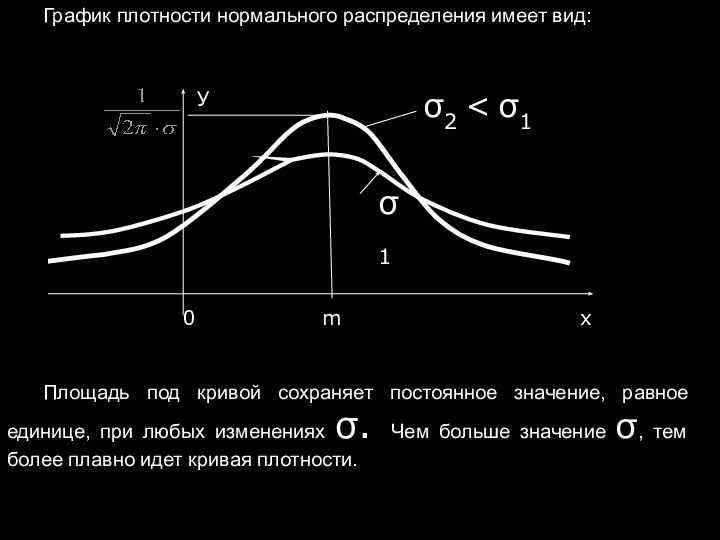

График плотности нормального распределения имеет вид:

σ1

Площадь под кривой

сохраняет постоянное значение, равное единице, при любых изменениях σ.

Чем больше значение σ, тем более плавно идет кривая плотности.

Слайд 47

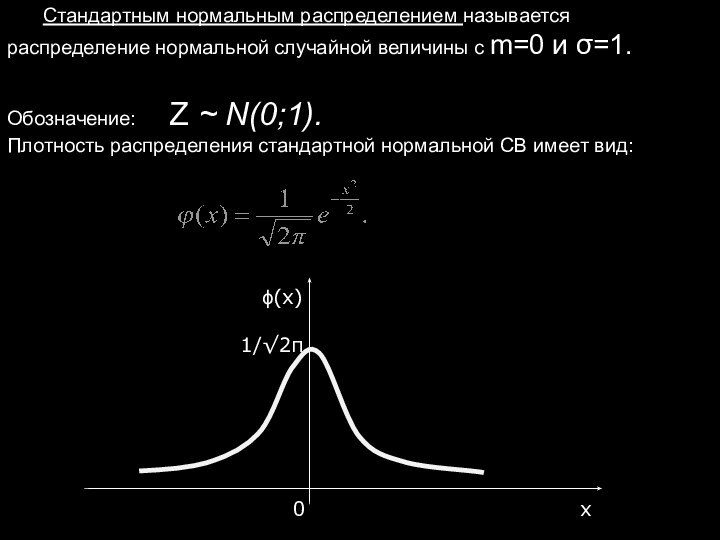

Стандартным нормальным распределением называется распределение нормальной случайной величины

с m=0 и σ=1.

Обозначение: Z ~ N(0;1).

Плотность

распределения стандартной нормальной СВ имеет вид:

Слайд 48

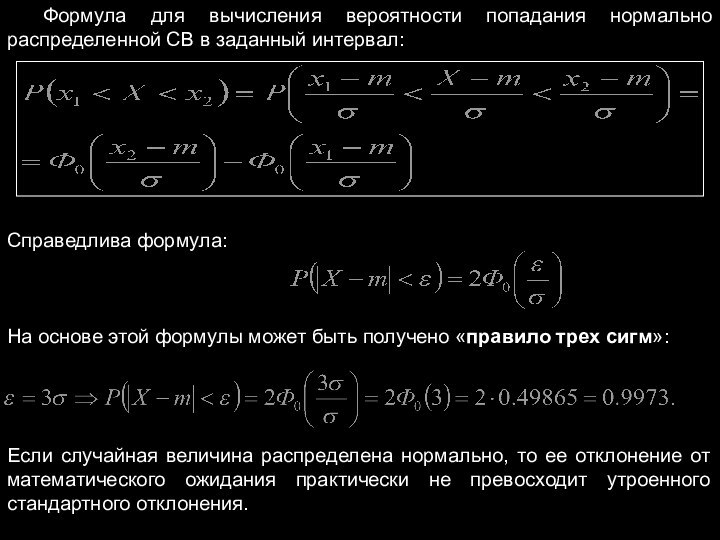

Формула для вычисления вероятности попадания нормально распределенной СВ

в заданный интервал:

Справедлива формула:

На основе этой формулы может быть

получено «правило трех сигм»:

Если случайная величина распределена нормально, то ее отклонение от математического ожидания практически не превосходит утроенного стандартного отклонения.

Слайд 49

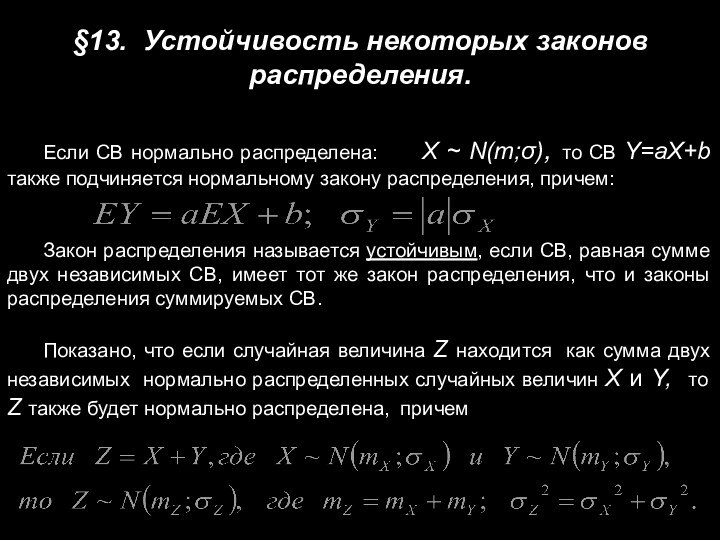

§13. Устойчивость некоторых законов распределения.

Если СВ нормально распределена:

X ~ N(m;σ), то СВ Y=aX+b также

подчиняется нормальному закону распределения, причем:

Закон распределения называется устойчивым, если СВ, равная сумме двух независимых СВ, имеет тот же закон распределения, что и законы распределения суммируемых СВ.

Показано, что если случайная величина Z находится как сумма двух независимых нормально распределенных случайных величин X и Y, то Z также будет нормально распределена, причем

Слайд 50

§14. Неравенство Чебышева.

Неравенство Маркова (или лемма Чебышева)

Если случайная

величина Х принимает только неотрицательные значения и имеет математическое

ожидание ЕХ, то для любого положительного числа α справедливо неравенство:

Предельные теоремы теории вероятностей.

Теорема (неравенство Чебышева):

Если случайная величина Х имеет математическое ожидание ЕХ и дисперсию DX, то для любого ε > 0 справедливо неравенство:

Слайд 51

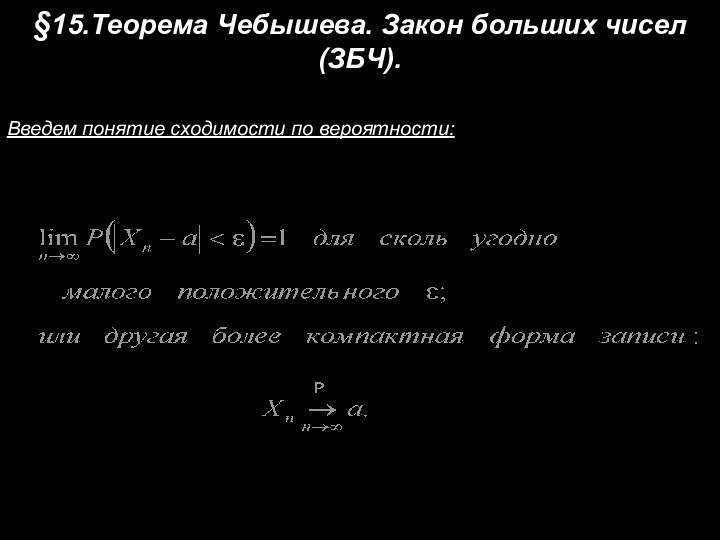

§15.Теорема Чебышева. Закон больших чисел (ЗБЧ).

Введем понятие сходимости

по вероятности:

Слайд 52

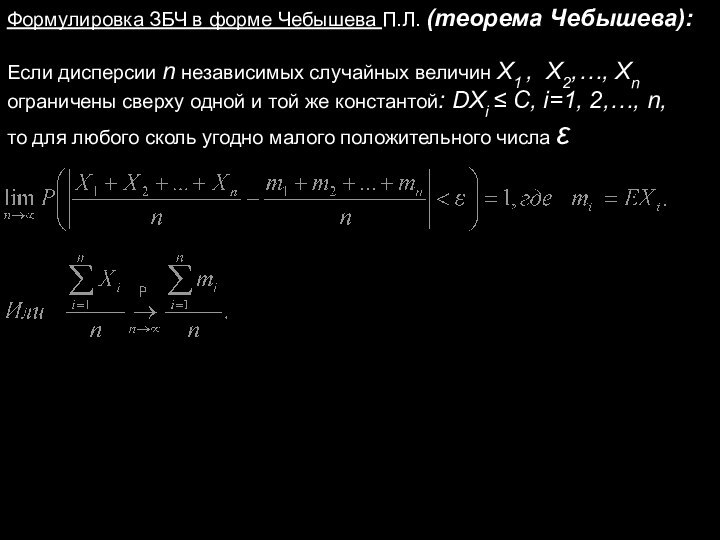

Формулировка ЗБЧ в форме Чебышева П.Л. (теорема Чебышева):

Если

дисперсии n независимых случайных величин Х1 , Х2,…, Хn

ограничены

сверху одной и той же константой: DXi ≤ C, i=1, 2,…, n,

то для любого сколь угодно малого положительного числа ε

Слайд 53

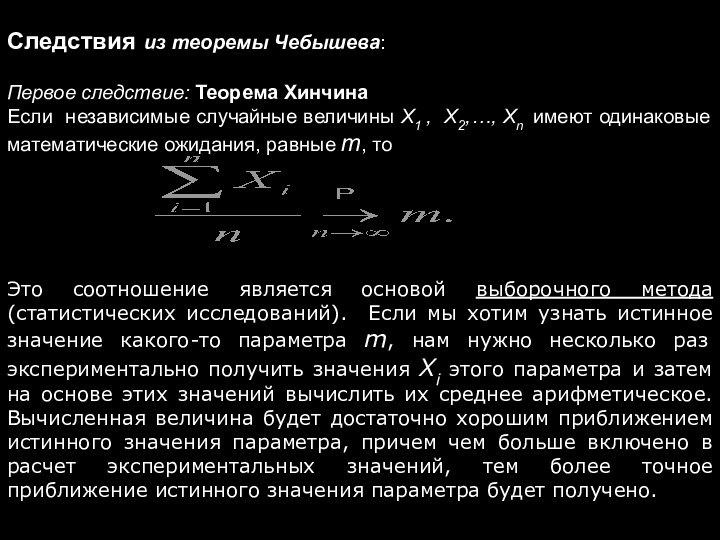

Следствия из теоремы Чебышева:

Первое следствие: Теорема Хинчина

Если

независимые случайные величины Х1 , Х2,…, Хn имеют одинаковые

математические ожидания, равные m, то

Это соотношение является основой выборочного метода (статистических исследований). Если мы хотим узнать истинное значение какого-то параметра m, нам нужно несколько раз экспериментально получить значения Xi этого параметра и затем на основе этих значений вычислить их среднее арифметическое. Вычисленная величина будет достаточно хорошим приближением истинного значения параметра, причем чем больше включено в расчет экспериментальных значений, тем более точное приближение истинного значения параметра будет получено.

Слайд 54

Второе следствие: Теорема Бернулли

Пусть проводится n независимых

испытаний, в каждом из которых событие А может произойти

с одной и той же вероятностью р (схема Бернулли). При неограниченном возрастании числа опытов n частота события А сходится по вероятности к вероятности р этого события в отдельном испытании:

Здесь k - количество случаев, когда событие А наблюдалось.

Слайд 55

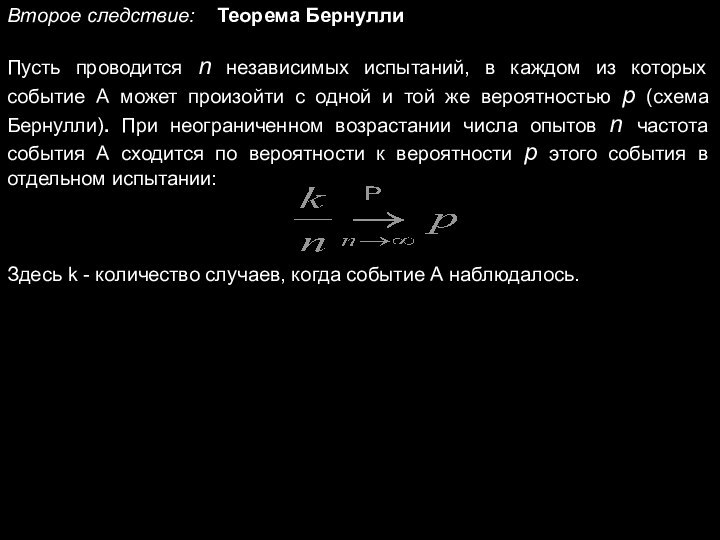

Третье следствие:

ЗБЧ может быть распространен и на

зависимые случайные величины ( это обобщение принадлежит Маркову А.А.):

Если

имеются зависимые случайные величины Х1 , Х2,…, Хn и если при

Слайд 56

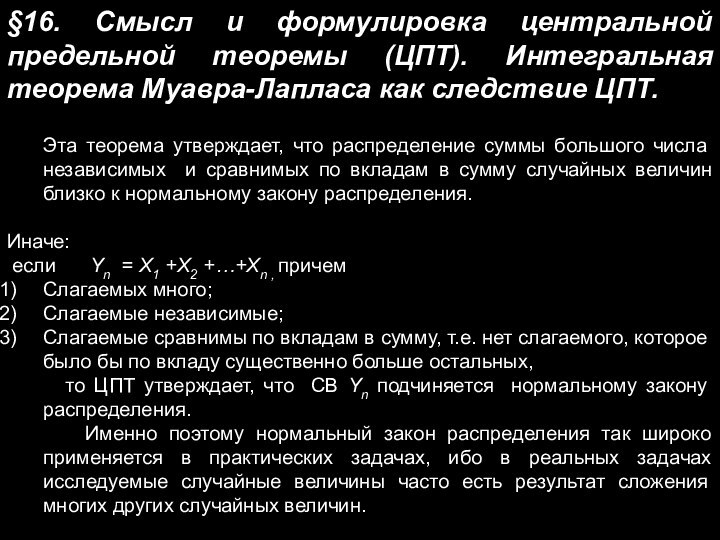

§16. Смысл и формулировка центральной предельной теоремы (ЦПТ).

Интегральная теорема Муавра-Лапласа как следствие ЦПТ.

Эта теорема утверждает, что

распределение суммы большого числа независимых и сравнимых по вкладам в сумму случайных величин близко к нормальному закону распределения.

Иначе:

если Yn = X1 +X2 +…+Xn , причем

Слагаемых много;

Слагаемые независимые;

Слагаемые сравнимы по вкладам в сумму, т.е. нет слагаемого, которое было бы по вкладу существенно больше остальных,

то ЦПТ утверждает, что СВ Yn подчиняется нормальному закону распределения.

Именно поэтому нормальный закон распределения так широко применяется в практических задачах, ибо в реальных задачах исследуемые случайные величины часто есть результат сложения многих других случайных величин.

Слайд 57

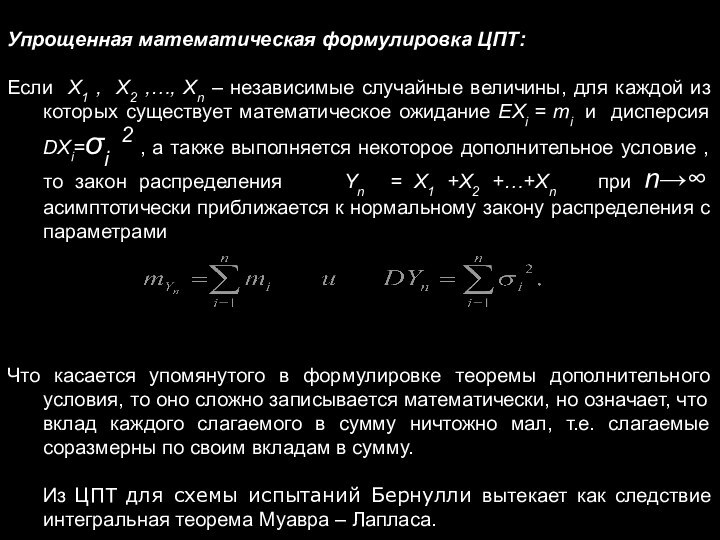

Упрощенная математическая формулировка ЦПТ:

Если X1 , X2 ,…,

Xn – независимые случайные величины, для каждой из которых

существует математическое ожидание EXi = mi и дисперсия DXi=σi 2 , а также выполняется некоторое дополнительное условие , то закон распределения Yn = X1 +X2 +…+Xn при n→∞ асимптотически приближается к нормальному закону распределения с параметрами

Что касается упомянутого в формулировке теоремы дополнительного условия, то оно сложно записывается математически, но означает, что вклад каждого слагаемого в сумму ничтожно мал, т.е. слагаемые соразмерны по своим вкладам в сумму.

Из ЦПТ для схемы испытаний Бернулли вытекает как следствие интегральная теорема Муавра – Лапласа.

Слайд 58

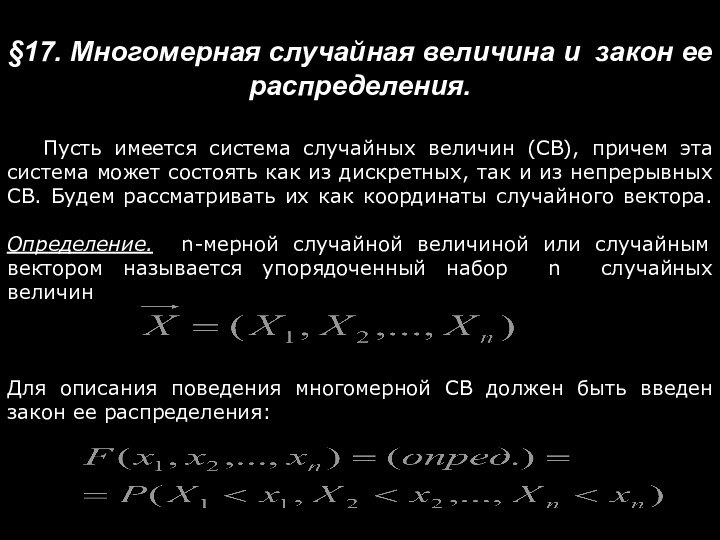

§17. Многомерная случайная величина и закон ее распределения.

Пусть имеется система случайных величин (СВ), причем эта система

может состоять как из дискретных, так и из непрерывных СВ. Будем рассматривать их как координаты случайного вектора.

Определение. n-мерной случайной величиной или случайным вектором называется упорядоченный набор n случайных величин

Для описания поведения многомерной СВ должен быть введен закон ее распределения:

Слайд 59

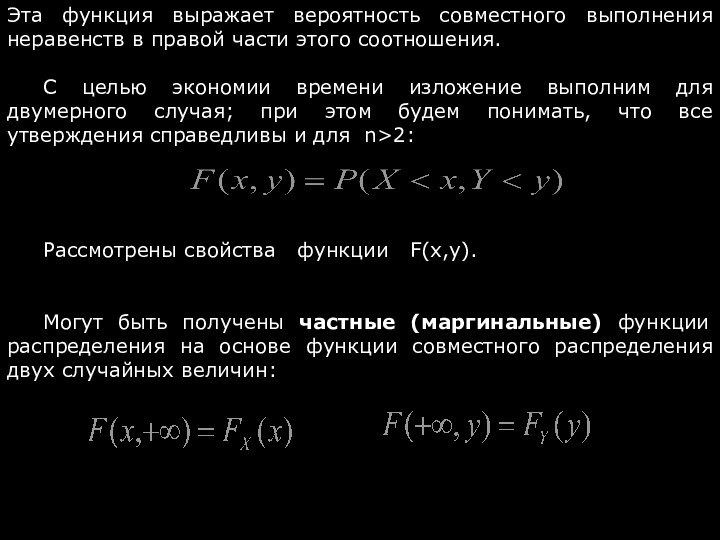

Эта функция выражает вероятность совместного выполнения неравенств в

правой части этого соотношения.

С целью экономии времени изложение выполним

для двумерного случая; при этом будем понимать, что все утверждения справедливы и для n>2:

Рассмотрены свойства функции F(x,y).

Могут быть получены частные (маргинальные) функции распределения на основе функции совместного распределения двух случайных величин:

Слайд 60

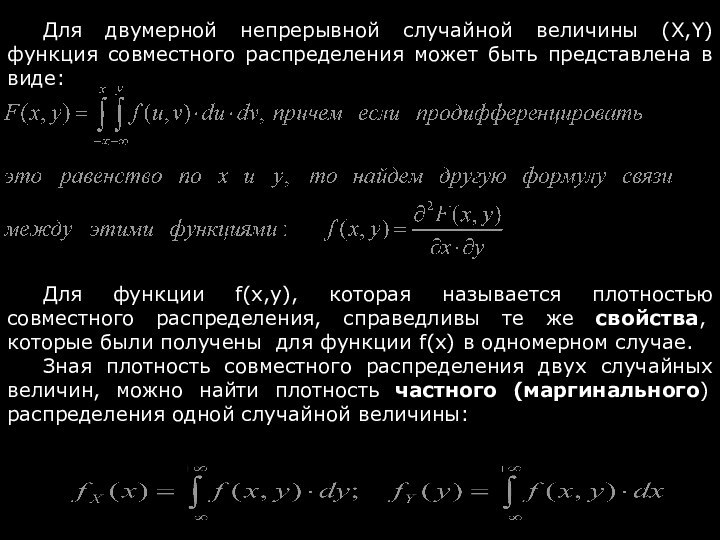

Для двумерной непрерывной случайной величины (X,Y) функция совместного

распределения может быть представлена в виде:

Для функции f(x,y), которая

называется плотностью совместного распределения, справедливы те же свойства, которые были получены для функции f(x) в одномерном случае.

Зная плотность совместного распределения двух случайных величин, можно найти плотность частного (маргинального) распределения одной случайной величины:

Слайд 61

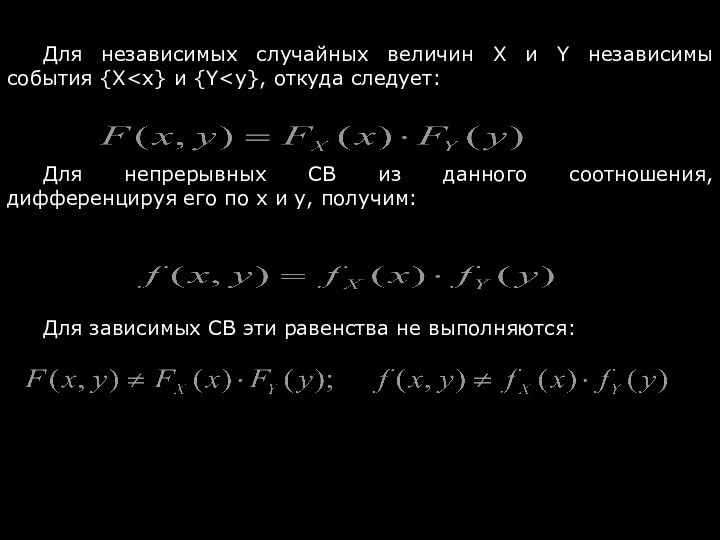

Для независимых случайных величин Х и Y

независимы события {X

из данного соотношения, дифференцируя его по x и y, получим:

Для зависимых СВ эти равенства не выполняются:

Слайд 62

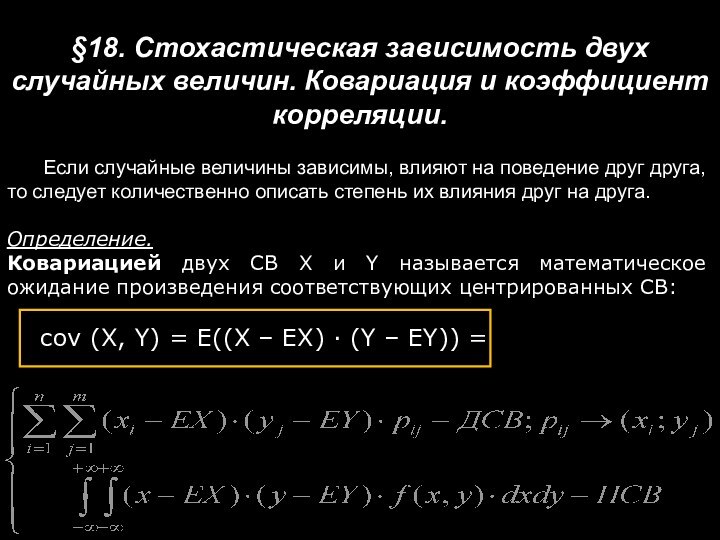

§18. Стохастическая зависимость двух случайных величин. Ковариация и

коэффициент корреляции.

Если случайные величины зависимы, влияют на поведение

друг друга, то следует количественно описать степень их влияния друг на друга.

Определение.

Ковариацией двух СВ X и Y называется математическое ожидание произведения соответствующих центрированных СВ:

cov (X, Y) = E((X – EX) · (Y – EY)) =

Слайд 63

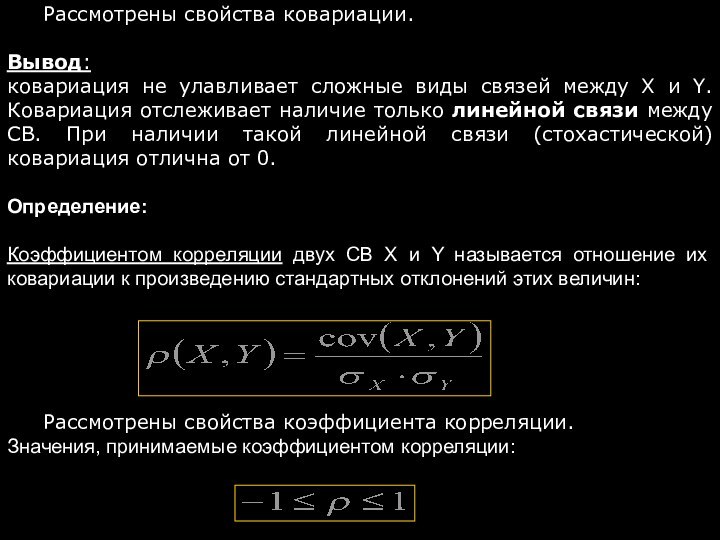

Рассмотрены свойства ковариации.

Вывод:

ковариация не улавливает сложные виды

связей между X и Y. Ковариация отслеживает наличие только

линейной связи между СВ. При наличии такой линейной связи (стохастической) ковариация отлична от 0.

Определение:

Коэффициентом корреляции двух СВ X и Y называется отношение их ковариации к произведению стандартных отклонений этих величин:

Рассмотрены свойства коэффициента корреляции.

Значения, принимаемые коэффициентом корреляции:

Слайд 64

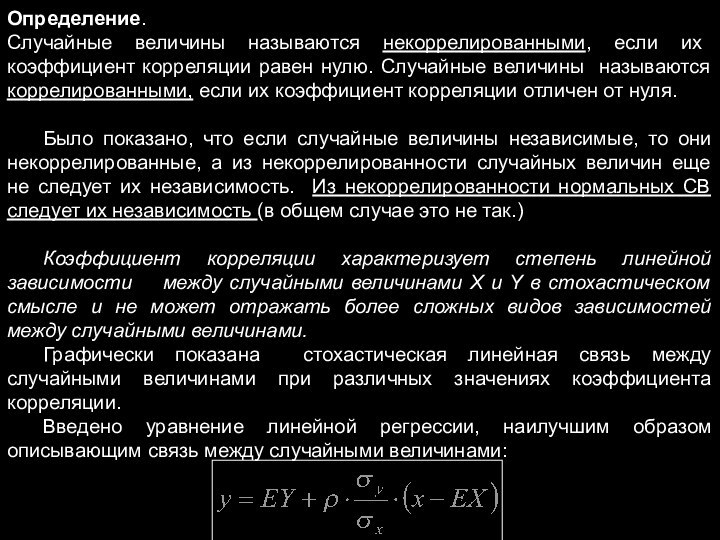

Определение.

Случайные величины называются некоррелированными, если их коэффициент корреляции

равен нулю. Случайные величины называются коррелированными, если их коэффициент

корреляции отличен от нуля.

Было показано, что если случайные величины независимые, то они некоррелированные, а из некоррелированности случайных величин еще не следует их независимость. Из некоррелированности нормальных СВ следует их независимость (в общем случае это не так.)

Коэффициент корреляции характеризует степень линейной зависимости между случайными величинами X и Y в стохастическом смысле и не может отражать более сложных видов зависимостей между случайными величинами.

Графически показана стохастическая линейная связь между случайными величинами при различных значениях коэффициента корреляции.

Введено уравнение линейной регрессии, наилучшим образом описывающим связь между случайными величинами:

Слайд 65

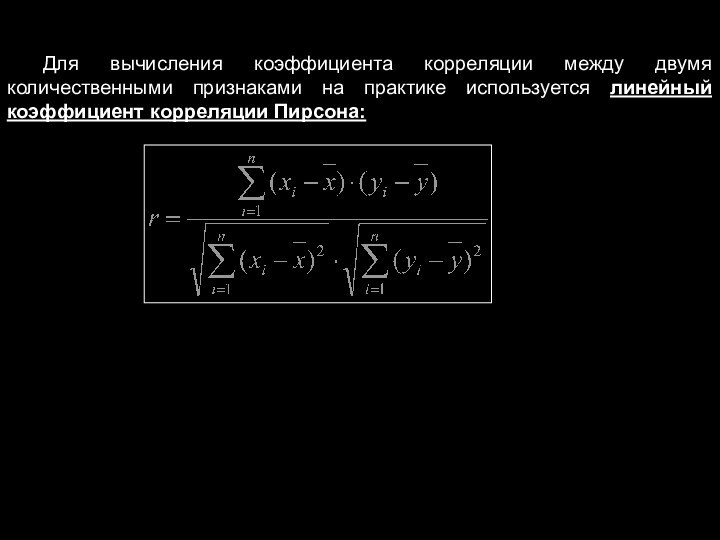

Для вычисления коэффициента корреляции между двумя количественными признаками

на практике используется линейный коэффициент корреляции Пирсона:

Слайд 66

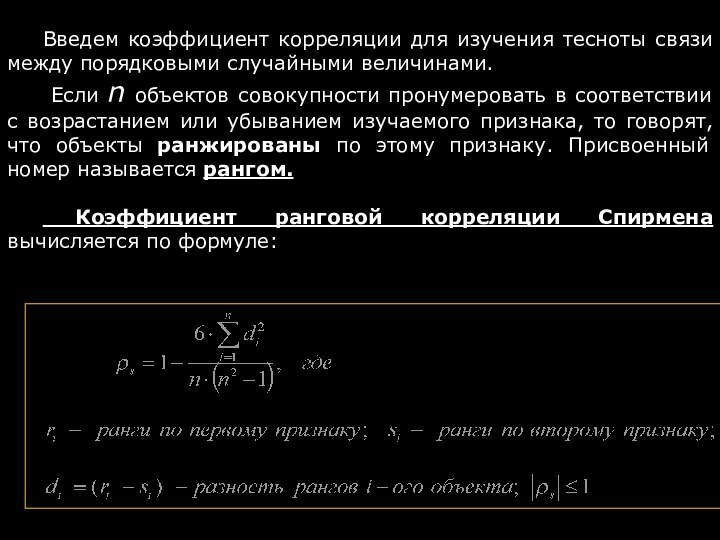

Введем коэффициент корреляции для изучения тесноты связи между

порядковыми случайными величинами.

Если n объектов совокупности пронумеровать в

соответствии с возрастанием или убыванием изучаемого признака, то говорят, что объекты ранжированы по этому признаку. Присвоенный номер называется рангом.

Коэффициент ранговой корреляции Спирмена вычисляется по формуле:

Слайд 67

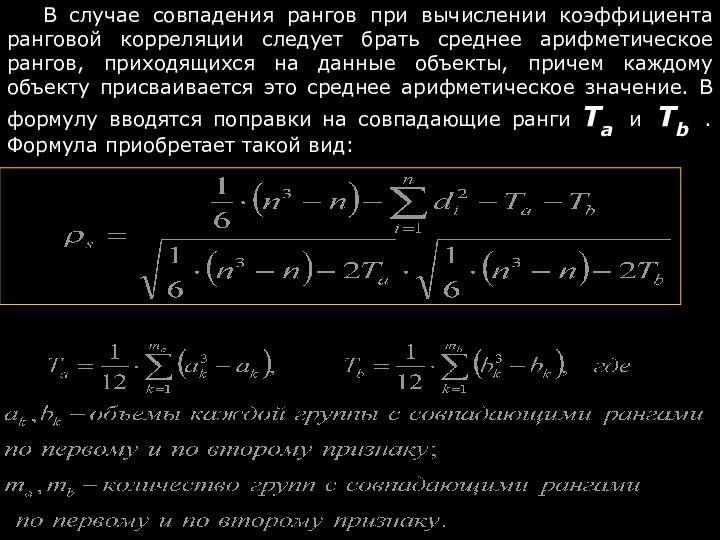

В случае совпадения рангов при вычислении коэффициента ранговой

корреляции следует брать среднее арифметическое рангов, приходящихся на данные

объекты, причем каждому объекту присваивается это среднее арифметическое значение. В формулу вводятся поправки на совпадающие ранги Ta и Tb . Формула приобретает такой вид:

Слайд 68

Раздел 2.

Элементы математической статистики.

Начнем с нового раздела нумерацию

параграфов заново.

§ 1. Случайные выборки. Первичная обработка статистических данных.

Вариационные ряды.

Статистика изучает большие массивы информации и устанавливает закономерности, которым подчиняются случайные массовые явления.

Слайд 69

Генеральной совокупностью (ГС) называется вся подлежащая изучению какого-либо

свойства (говорят, признака) совокупность объектов.

Та часть объектов, которая отобрана

для непосредственного изучения какого-либо признака ГС носит название случайной выборки (или просто выборки).

Объем ГС и объем выборки – это количество элементов в них. Обозначаются , соответственно, N и n.

В дальнейшем будем считать, что объем выборки существенно меньше объема генеральной совокупности. В этом случае получаемые в дальнейшем формулы являются наиболее простыми.

Непрерывная природа изучаемого признака порождает бесконечные ГС.

Слайд 70

Для того, чтобы выборка была репрезентативной (хорошо представлять

элементы ГС), она должна быть отобрана случайно. Случайность отбора

элементов в выборку достигается соблюдением принципа равной возможности каждого элемента ГС быть отобранным в выборку.

Нарушение принципов случайного выбора приводит к серьезным ошибкам.

Любое число, полученное на основе выборки, носит название «выборочная статистика» (или просто «статистика»).

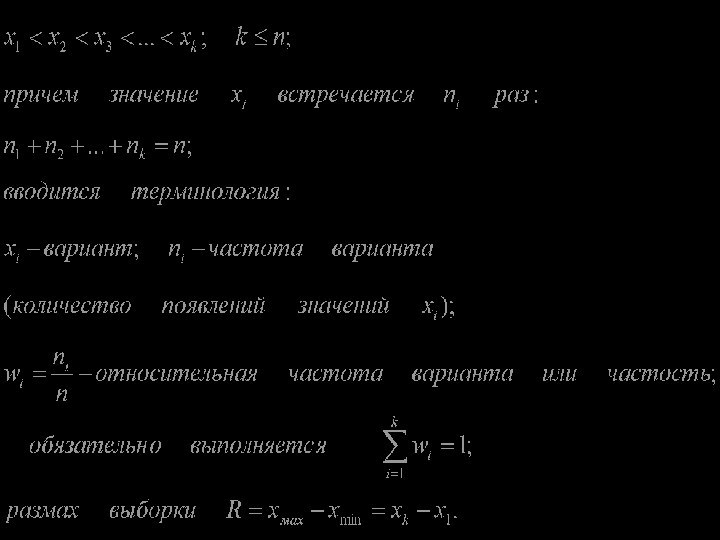

Пусть получена выборка объема n. Над этим массивом исходных данных выполняется операция ранжирования, т.е. экспериментальные данные выстраиваются в порядке возрастания:

Слайд 72

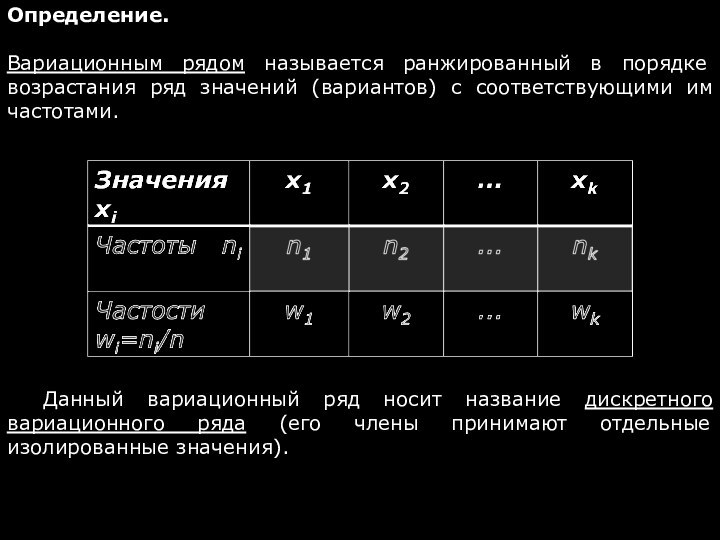

Определение.

Вариационным рядом называется ранжированный в порядке возрастания ряд

значений (вариантов) с соответствующими им частотами.

Данный вариационный ряд носит

название дискретного вариационного ряда (его члены принимают отдельные изолированные значения).

Слайд 73

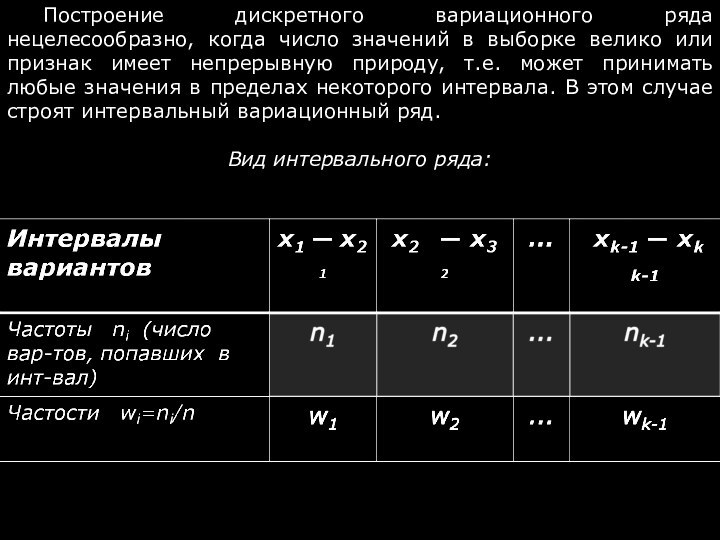

Построение дискретного вариационного ряда нецелесообразно, когда число значений

в выборке велико или признак имеет непрерывную природу, т.е.

может принимать любые значения в пределах некоторого интервала. В этом случае строят интервальный вариационный ряд.

Вид интервального ряда:

Слайд 74

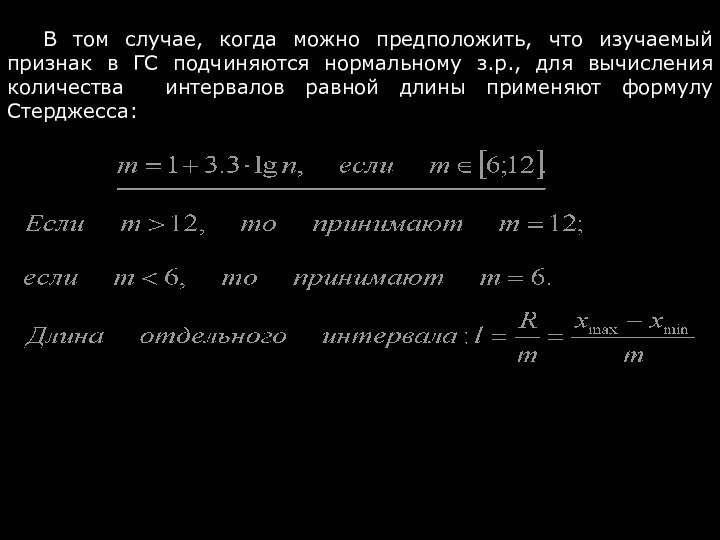

В том случае, когда можно предположить, что изучаемый

признак в ГС подчиняются нормальному з.р., для вычисления количества

интервалов равной длины применяют формулу Стерджесса:

Слайд 75

Существуют различные приёмы изображения набора данных, которые дают

визуальное представление об основных свойствах экспериментальных данных в целом.

Чаще всего для этого используются: полигон, гистограмма, кумулята. Графическое представление вариационных рядов делает картину поведения статистических данных более наглядной.

Полигон распределения частот используется для изображения дискретного вариационного ряда и представляет собой ломаную линию, отрезки которой соединяют точки с координатами (xi ,wi).

Слайд 76

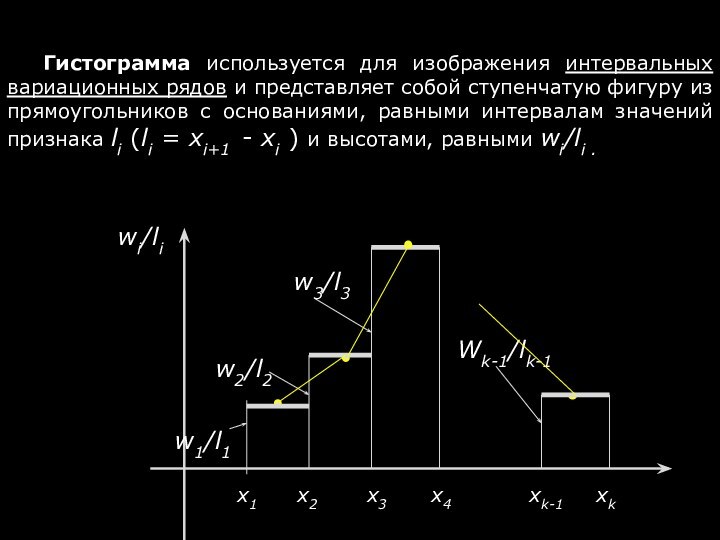

Гистограмма используется для изображения интервальных вариационных рядов и

представляет собой ступенчатую фигуру из прямоугольников с основаниями, равными

интервалам значений признака li (li = xi+1 - xi ) и высотами, равными wi/li .

Слайд 77

Эмпирической функцией распределения Fn(x) называется относительная частота того,

что случайная величина принимает значение меньше заданного:

Fn(x) = W(X

Для графического изображения эмпирической функции распределения служит кумулята. Строим ее, соединяя точки (xi , Wiнак ).

Слайд 78

Следует дополнить вариационные ряды и их графическое изображение

некоторыми сводными характеристиками вариационных рядов.

Эти обобщающие показатели в

компактном виде характеризуют всю выборку (вариационный ряд) в целом. К таким обобщающим показателям относят:

Характеристики центральной тенденции - это средние величины, определяющие значения признака, вокруг которого концентрируются все его наблюдаемые значения;

Характеристики вариации (изменчивости) – это величины, определяющие колебания наблюдаемых значений признака.

В качестве основной характеристики центральной тенденции чаще всего используют среднее арифметическое, вычисленной на основе выборки. Помимо этой величины используют моду и медиану.

Слайд 79

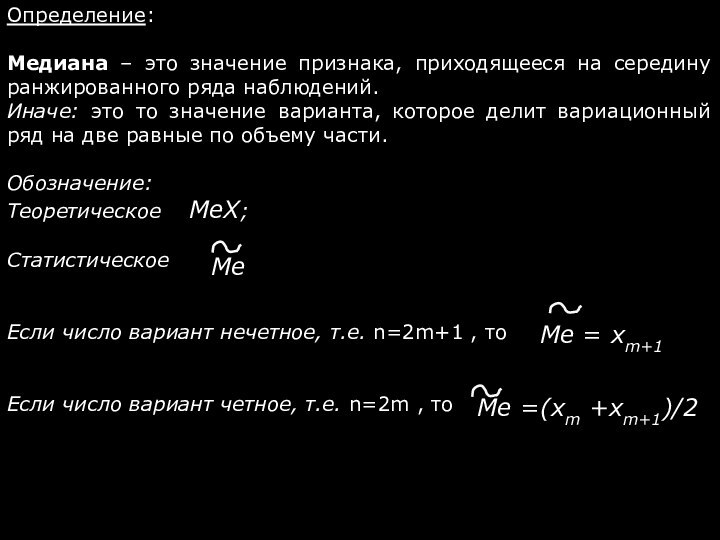

Определение:

Медиана – это значение признака, приходящееся на середину

ранжированного ряда наблюдений.

Иначе: это то значение варианта, которое делит

вариационный ряд на две равные по объему части.

Обозначение:

Теоретическое MeX;

Статистическое

Если число вариант нечетное, т.е. n=2m+1 , то

Если число вариант четное, т.е. n=2m , то

Слайд 80

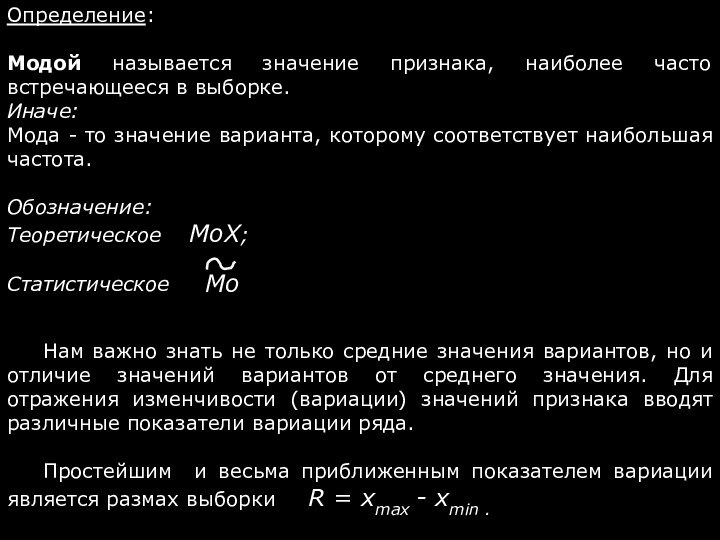

Определение:

Модой называется значение признака, наиболее часто встречающееся в

выборке.

Иначе:

Мода - то значение варианта, которому соответствует

наибольшая частота.

Обозначение:

Теоретическое MоX;

Статистическое

Нам важно знать не только средние значения вариантов, но и отличие значений вариантов от среднего значения. Для отражения изменчивости (вариации) значений признака вводят различные показатели вариации ряда.

Простейшим и весьма приближенным показателем вариации является размах выборки R = xmax - xmin .

Слайд 81

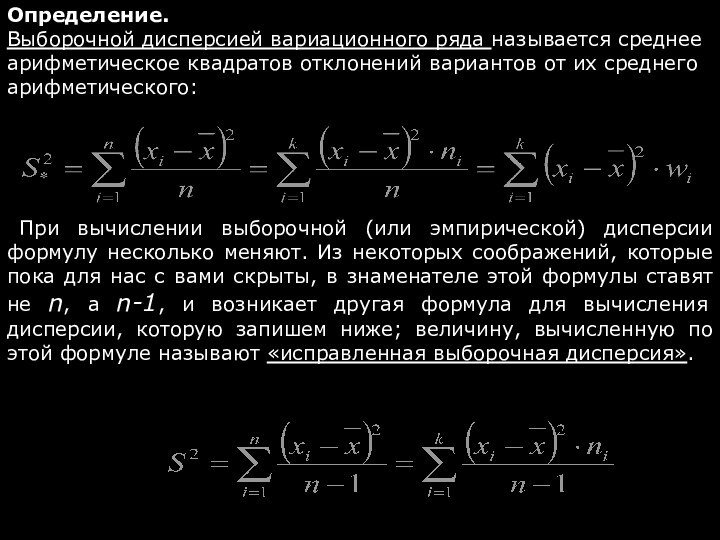

Определение.

Выборочной дисперсией вариационного ряда называется среднее арифметическое квадратов

отклонений вариантов от их среднего арифметического:

При вычислении выборочной

(или эмпирической) дисперсии формулу несколько меняют. Из некоторых соображений, которые пока для нас с вами скрыты, в знаменателе этой формулы ставят не n, а n-1, и возникает другая формула для вычисления дисперсии, которую запишем ниже; величину, вычисленную по этой формуле называют «исправленная выборочная дисперсия».

Слайд 82

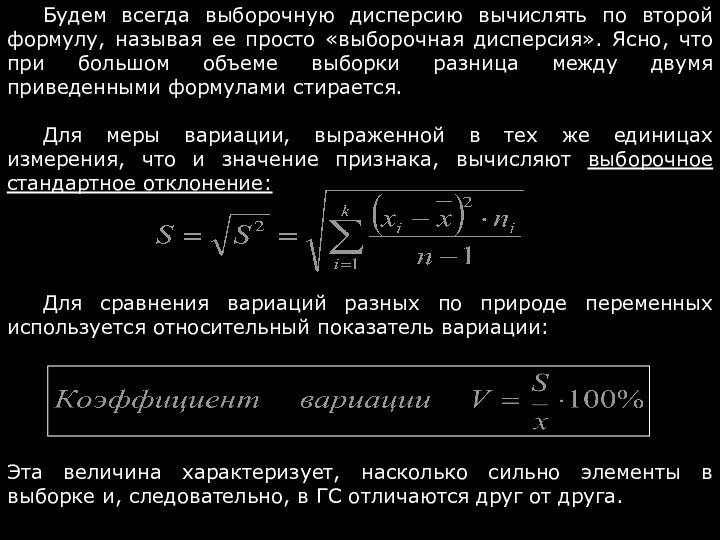

Будем всегда выборочную дисперсию вычислять по второй формулу,

называя ее просто «выборочная дисперсия». Ясно, что при большом

объеме выборки разница между двумя приведенными формулами стирается.

Для меры вариации, выраженной в тех же единицах измерения, что и значение признака, вычисляют выборочное стандартное отклонение:

Для сравнения вариаций разных по природе переменных используется относительный показатель вариации:

Эта величина характеризует, насколько сильно элементы в выборке и, следовательно, в ГС отличаются друг от друга.

Слайд 83

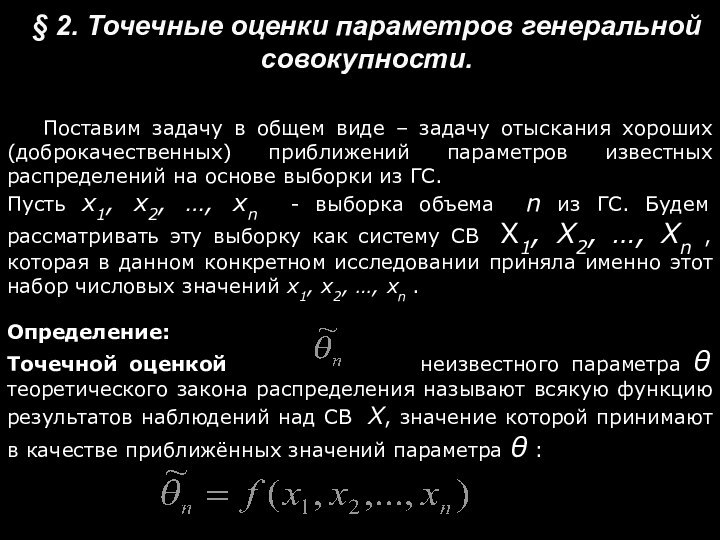

§ 2. Точечные оценки параметров генеральной совокупности.

Поставим задачу

в общем виде – задачу отыскания хороших (доброкачественных) приближений

параметров известных распределений на основе выборки из ГС.

Пусть x1, x2, …, xn - выборка объема n из ГС. Будем рассматривать эту выборку как систему СВ X1, X2, …, Xn , которая в данном конкретном исследовании приняла именно этот набор числовых значений x1, x2, …, xn .

Определение:

Точечной оценкой неизвестного параметра θ теоретического закона распределения называют всякую функцию результатов наблюдений над СВ X, значение которой принимают в качестве приближённых значений параметра θ :

Слайд 84

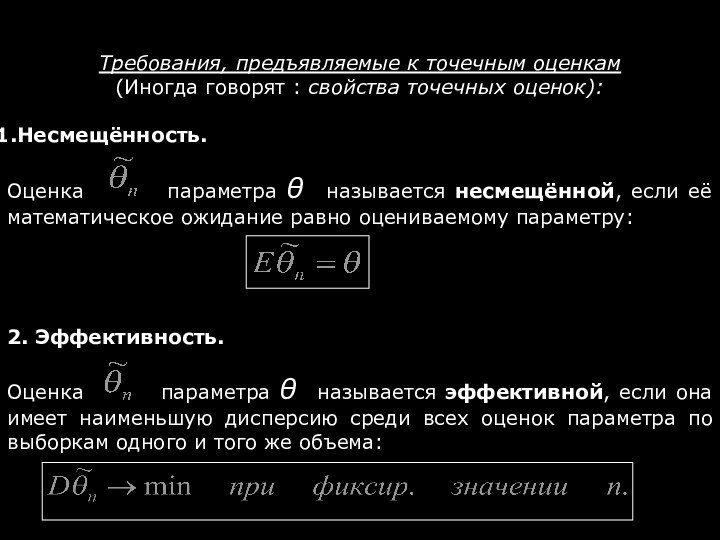

Требования, предъявляемые к точечным оценкам

(Иногда говорят :

свойства точечных оценок):

Несмещённость.

Оценка параметра θ

называется несмещённой, если её математическое ожидание равно оцениваемому параметру:

2. Эффективность.

Оценка параметра θ называется эффективной, если она имеет наименьшую дисперсию среди всех оценок параметра по выборкам одного и того же объема:

Слайд 85

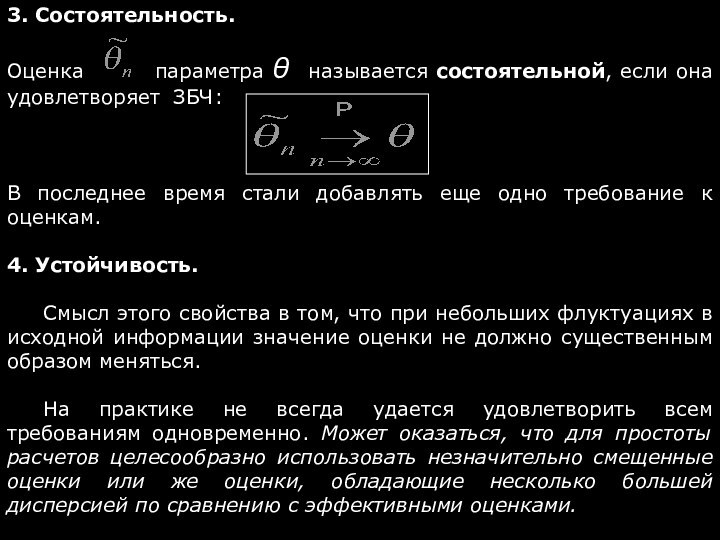

3. Состоятельность.

Оценка параметра

θ называется состоятельной, если она удовлетворяет ЗБЧ:

В последнее время

стали добавлять еще одно требование к оценкам.

4. Устойчивость.

Смысл этого свойства в том, что при небольших флуктуациях в исходной информации значение оценки не должно существенным образом меняться.

На практике не всегда удается удовлетворить всем требованиям одновременно. Может оказаться, что для простоты расчетов целесообразно использовать незначительно смещенные оценки или же оценки, обладающие несколько большей дисперсией по сравнению с эффективными оценками.

Слайд 86

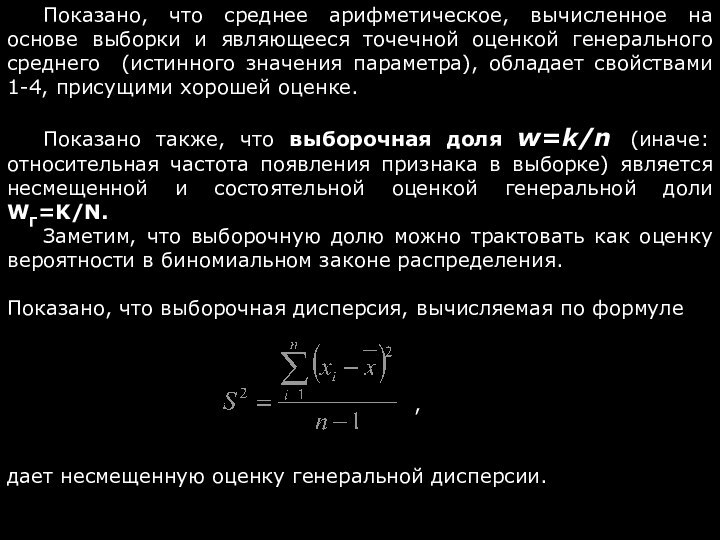

Показано, что среднее арифметическое, вычисленное на основе выборки

и являющееся точечной оценкой генерального среднего (истинного значения параметра),

обладает свойствами 1-4, присущими хорошей оценке.

Показано также, что выборочная доля w=k/n (иначе: относительная частота появления признака в выборке) является несмещенной и состоятельной оценкой генеральной доли WГ=K/N.

Заметим, что выборочную долю можно трактовать как оценку вероятности в биномиальном законе распределения.

Показано, что выборочная дисперсия, вычисляемая по формуле

,

дает несмещенную оценку генеральной дисперсии.

Слайд 87

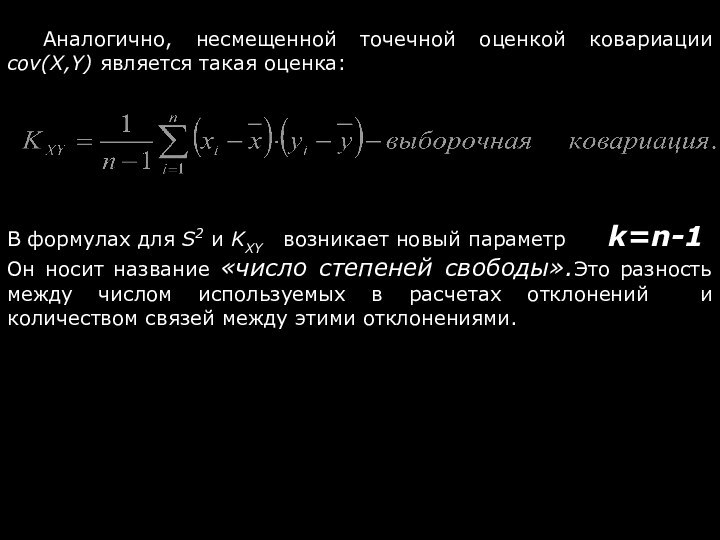

Аналогично, несмещенной точечной оценкой ковариации cov(X,Y) является такая

оценка:

В формулах для S2 и KXY возникает новый

параметр k=n-1

Он носит название «число степеней свободы».Это разность между числом используемых в расчетах отклонений и количеством связей между этими отклонениями.

Слайд 88

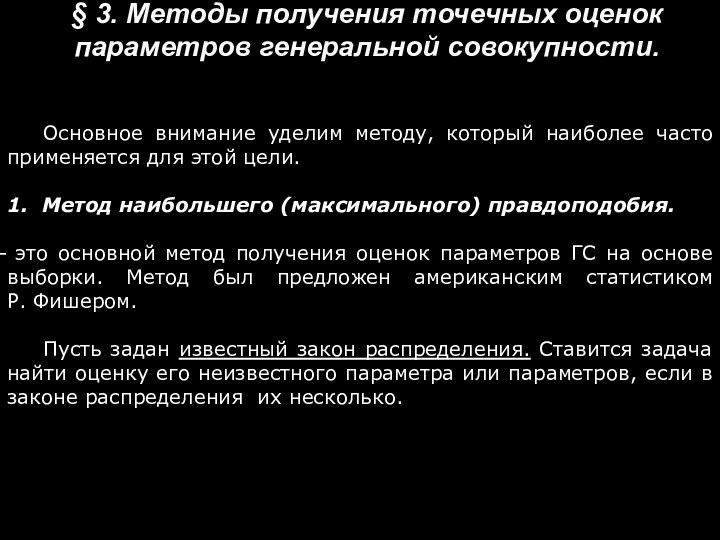

§ 3. Методы получения точечных оценок параметров генеральной

совокупности.

Основное внимание уделим методу, который наиболее часто применяется для

этой цели.

1. Метод наибольшего (максимального) правдоподобия.

это основной метод получения оценок параметров ГС на основе выборки. Метод был предложен американским статистиком Р. Фишером.

Пусть задан известный закон распределения. Ставится задача найти оценку его неизвестного параметра или параметров, если в законе распределения их несколько.

Слайд 89

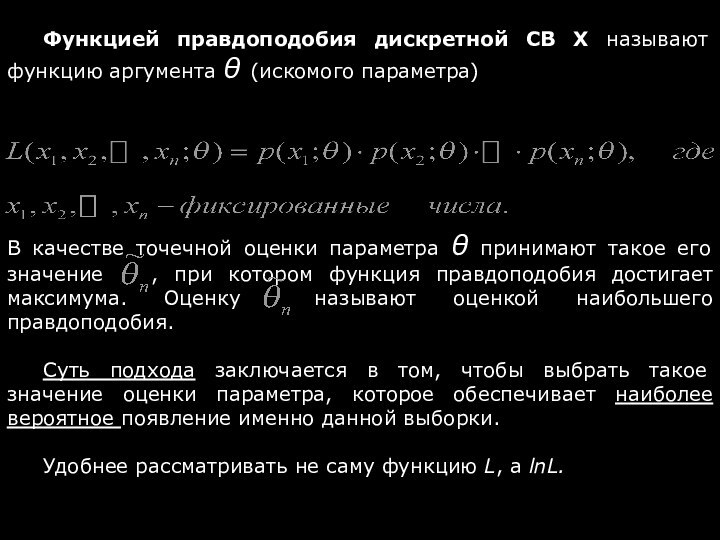

Функцией правдоподобия дискретной СВ Х называют функцию

аргумента θ (искомого параметра)

В качестве точечной оценки параметра θ

принимают такое его значение , при котором функция правдоподобия достигает максимума. Оценку называют оценкой наибольшего правдоподобия.

Суть подхода заключается в том, чтобы выбрать такое значение оценки параметра, которое обеспечивает наиболее вероятное появление именно данной выборки.

Удобнее рассматривать не саму функцию L, а lnL.

Слайд 90

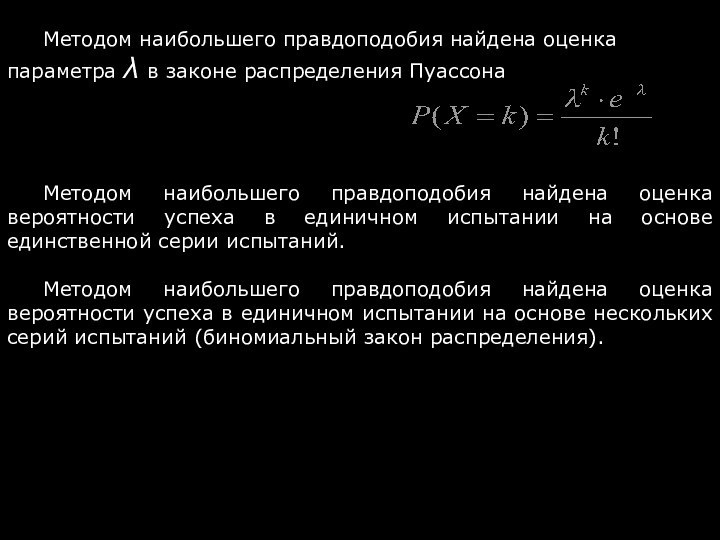

Методом наибольшего правдоподобия найдена оценка параметра λ в

законе распределения Пуассона

Методом наибольшего правдоподобия найдена оценка вероятности успеха

в единичном испытании на основе единственной серии испытаний.

Методом наибольшего правдоподобия найдена оценка вероятности успеха в единичном испытании на основе нескольких серий испытаний (биномиальный закон распределения).

Слайд 91

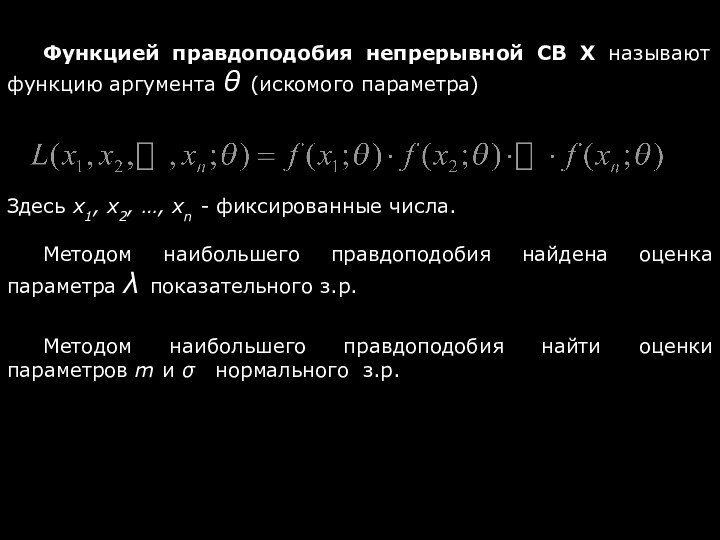

Функцией правдоподобия непрерывной СВ Х называют функцию аргумента

θ (искомого параметра)

Здесь x1, x2, …, xn - фиксированные

числа.

Методом наибольшего правдоподобия найдена оценка параметра λ показательного з.р.

Методом наибольшего правдоподобия найти оценки параметров m и σ нормального з.р.

Слайд 92

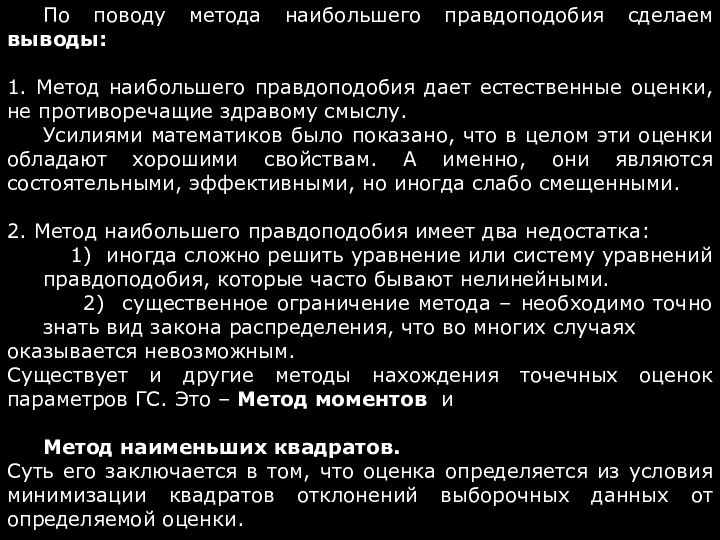

По поводу метода наибольшего правдоподобия сделаем выводы:

1. Метод

наибольшего правдоподобия дает естественные оценки, не противоречащие здравому смыслу.

Усилиями

математиков было показано, что в целом эти оценки обладают хорошими свойствам. А именно, они являются состоятельными, эффективными, но иногда слабо смещенными.

2. Метод наибольшего правдоподобия имеет два недостатка:

1) иногда сложно решить уравнение или систему уравнений правдоподобия, которые часто бывают нелинейными.

2) существенное ограничение метода – необходимо точно знать вид закона распределения, что во многих случаях оказывается невозможным.

Существует и другие методы нахождения точечных оценок параметров ГС. Это – Метод моментов и

Метод наименьших квадратов.

Суть его заключается в том, что оценка определяется из условия минимизации квадратов отклонений выборочных данных от определяемой оценки.

Слайд 93

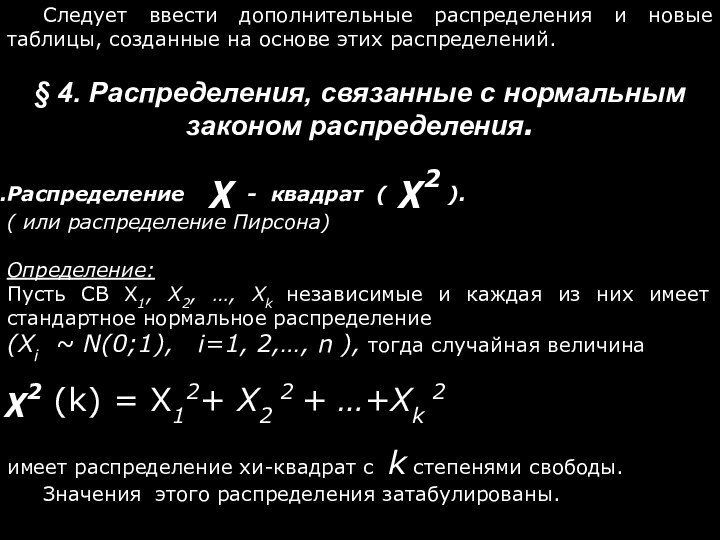

Следует ввести дополнительные распределения и новые таблицы, созданные

на основе этих распределений.

§ 4. Распределения, связанные с нормальным

законом распределения.

Распределение χ - квадрат ( χ2 ).

( или распределение Пирсона)

Определение:

Пусть СВ X1, X2, …, Xk независимые и каждая из них имеет стандартное нормальное распределение

(Xi ~ N(0;1), i=1, 2,…, n ), тогда случайная величина

χ2 (k) = X12+ X2 2 + …+Xk 2

имеет распределение хи-квадрат с k степенями свободы.

Значения этого распределения затабулированы.

Слайд 94

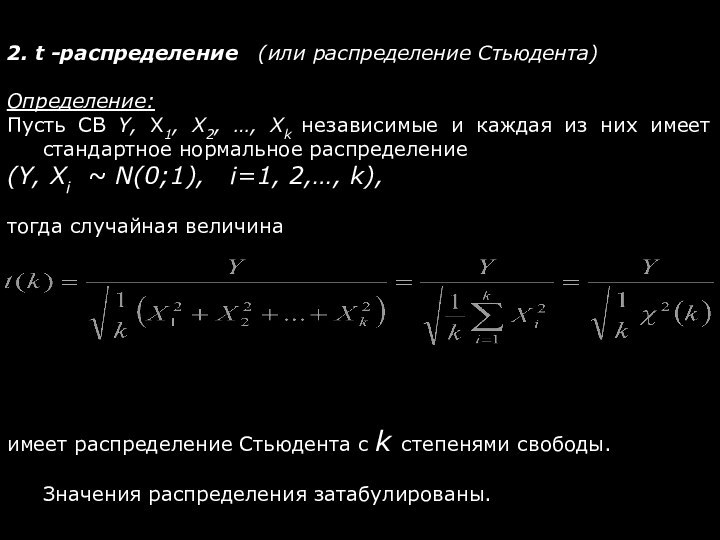

2. t -распределение (или распределение Стьюдента)

Определение:

Пусть СВ

Y, X1, X2, …, Xk независимые и каждая из

них имеет стандартное нормальное распределение

(Y, Xi ~ N(0;1), i=1, 2,…, k),

тогда случайная величина

имеет распределение Стьюдента c k степенями свободы.

Значения распределения затабулированы.

Слайд 95

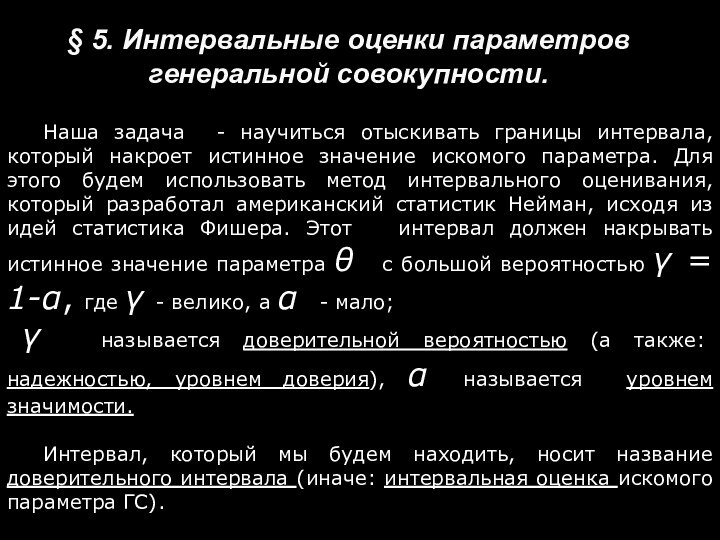

§ 5. Интервальные оценки параметров генеральной совокупности.

Наша задача

- научиться отыскивать границы интервала, который накроет истинное значение

искомого параметра. Для этого будем использовать метод интервального оценивания, который разработал американский статистик Нейман, исходя из идей статистика Фишера. Этот интервал должен накрывать истинное значение параметра θ с большой вероятностью γ = 1-α, где γ - велико, а α - мало;

γ называется доверительной вероятностью (а также: надежностью, уровнем доверия), α называется уровнем значимости.

Интервал, который мы будем находить, носит название доверительного интервала (иначе: интервальная оценка искомого параметра ГС).

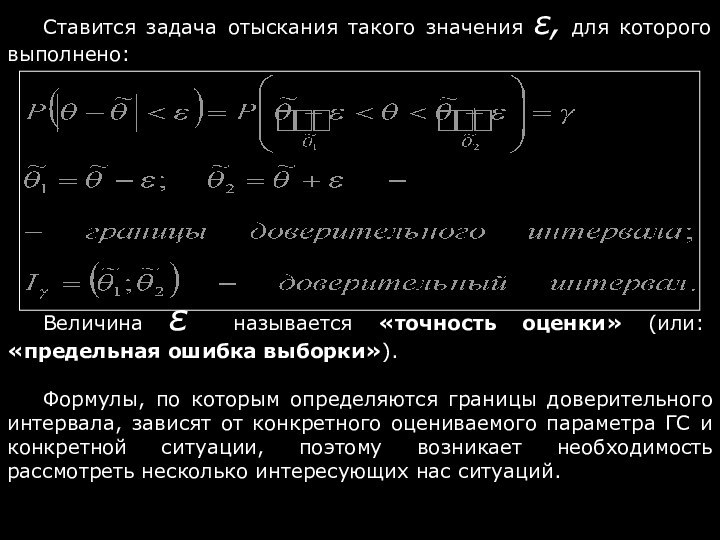

Слайд 96

Ставится задача отыскания такого значения ε, для которого

выполнено:

Величина ε называется «точность оценки» (или: «предельная ошибка выборки»).

Формулы,

по которым определяются границы доверительного интервала, зависят от конкретного оцениваемого параметра ГС и конкретной ситуации, поэтому возникает необходимость рассмотреть несколько интересующих нас ситуаций.

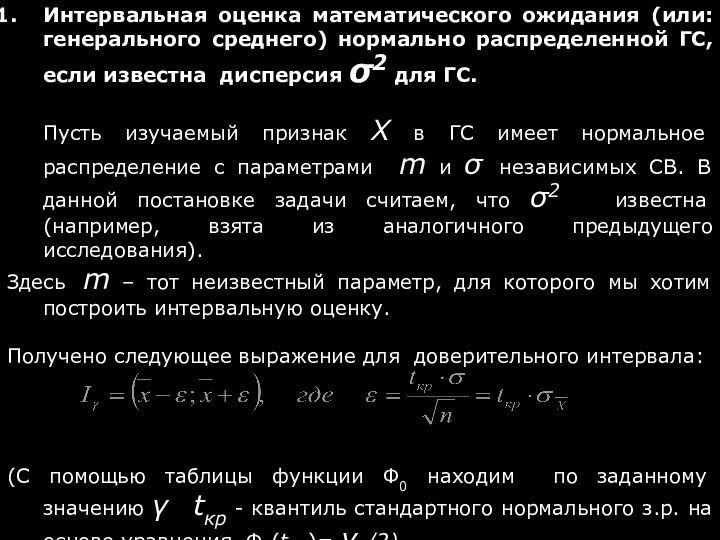

Слайд 97

Интервальная оценка математического ожидания (или: генерального среднего) нормально

распределенной ГС, если известна дисперсия σ2 для ГС.

Пусть изучаемый

признак Х в ГС имеет нормальное распределение с параметрами m и σ независимых СВ. В данной постановке задачи считаем, что σ2 известна (например, взята из аналогичного предыдущего исследования).

Здесь m – тот неизвестный параметр, для которого мы хотим построить интервальную оценку.

Получено следующее выражение для доверительного интервала:

(С помощью таблицы функции Ф0 находим по заданному значению γ tкр - квантиль стандартного нормального з.р. на основе уравнения Ф0(tкр )= γ /2).

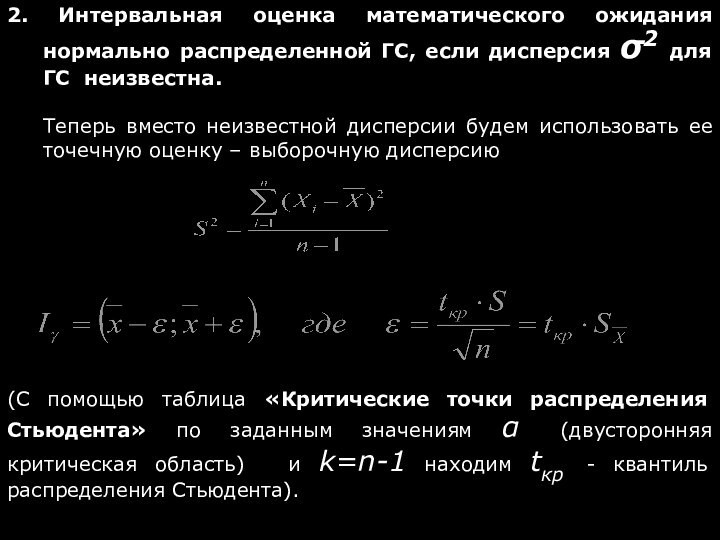

Слайд 98

2. Интервальная оценка математического ожидания нормально распределенной ГС,

если дисперсия σ2 для ГС неизвестна.

Теперь вместо неизвестной дисперсии

будем использовать ее точечную оценку – выборочную дисперсию

(С помощью таблица «Критические точки распределения Стьюдента» по заданным значениям α (двусторонняя критическая область) и k=n-1 находим tкр - квантиль распределения Стьюдента).

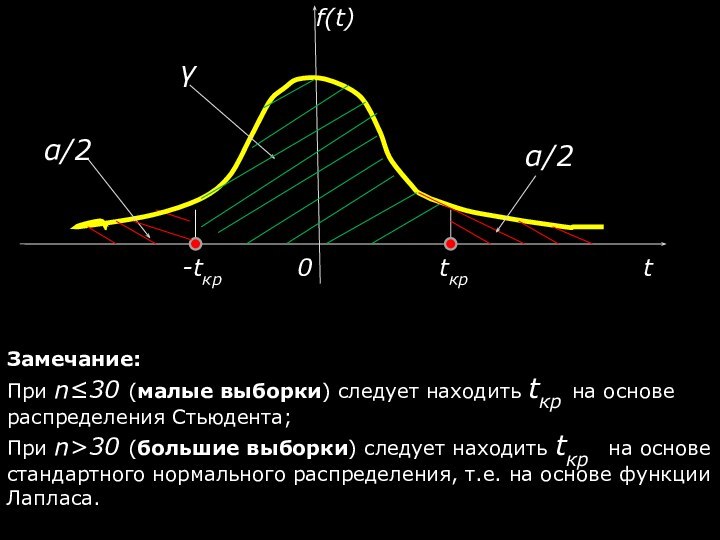

Слайд 99

Замечание:

При n≤30 (малые выборки) следует находить tкр на

основе распределения Стьюдента;

При n>30 (большие выборки) следует находить tкр

на основе стандартного нормального распределения, т.е. на основе функции Лапласа.

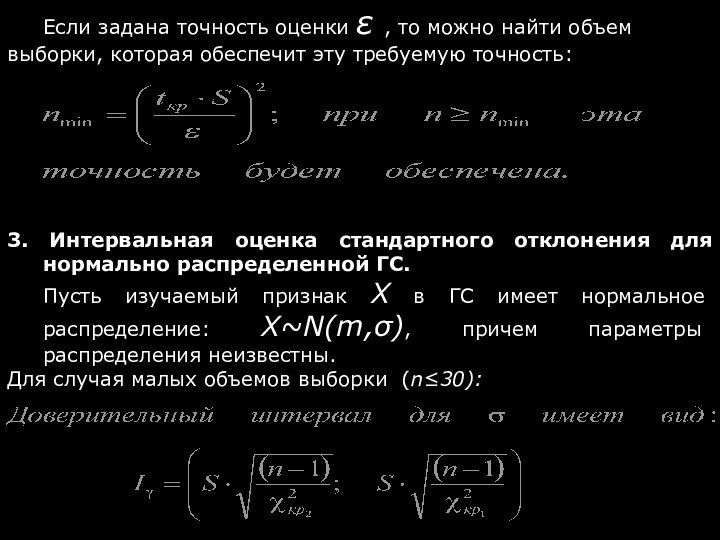

Слайд 100

Если задана точность оценки ε , то можно

найти объем выборки, которая обеспечит эту требуемую точность:

3. Интервальная

оценка стандартного отклонения для нормально распределенной ГС.

Пусть изучаемый признак Х в ГС имеет нормальное распределение: X~N(m,σ), причем параметры распределения неизвестны.

Для случая малых объемов выборки (n≤30):

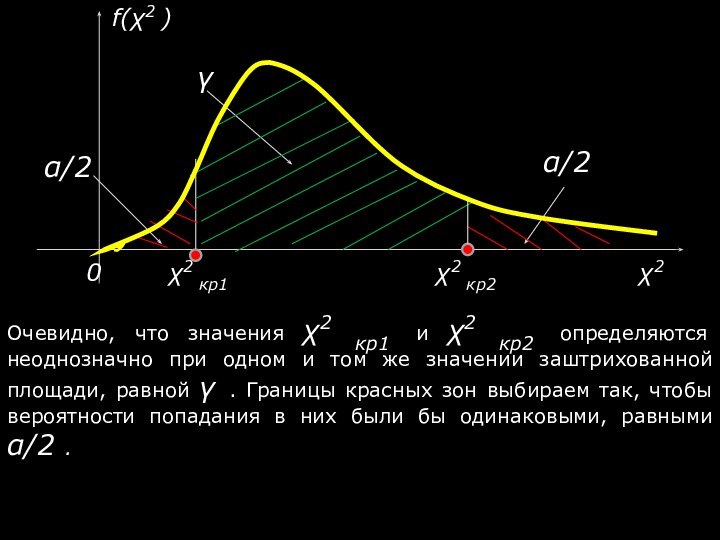

Слайд 101

Очевидно, что значения χ2 кр1 и χ2 кр2

определяются неоднозначно при одном и том же значении заштрихованной

площади, равной γ . Границы красных зон выбираем так, чтобы вероятности попадания в них были бы одинаковыми, равными α/2 .

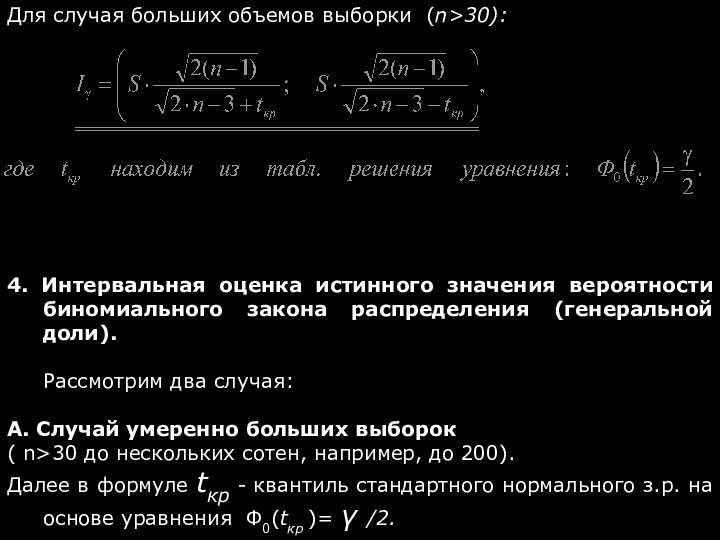

Слайд 102

Для случая больших объемов выборки (n>30):

4. Интервальная

оценка истинного значения вероятности биномиального закона распределения (генеральной доли).

Рассмотрим

два случая:

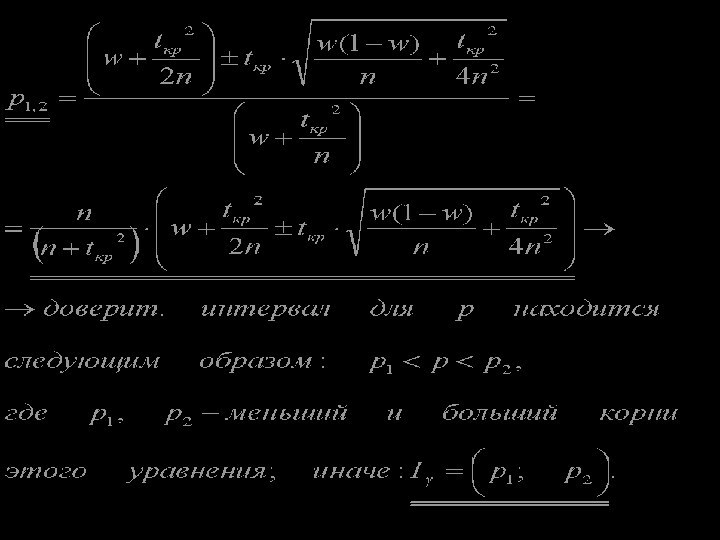

А. Случай умеренно больших выборок

( n>30 до нескольких сотен, например, до 200).

Далее в формуле tкр - квантиль стандартного нормального з.р. на основе уравнения Ф0(tкр )= γ /2.

Слайд 104

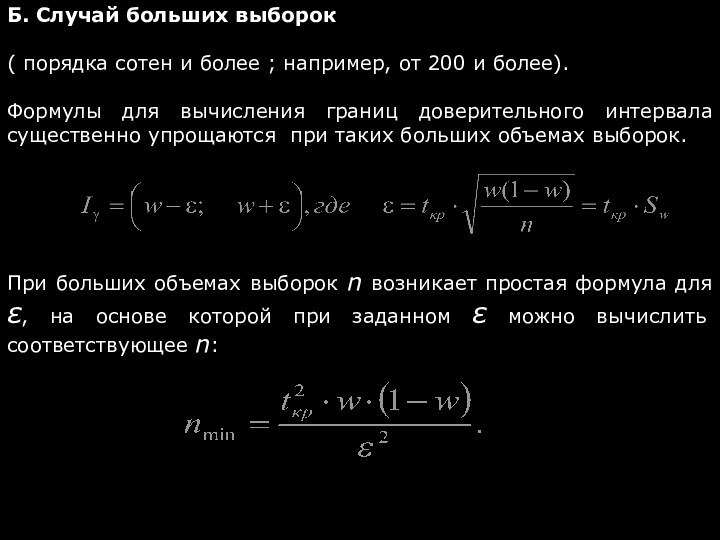

Б. Случай больших выборок

( порядка сотен и более

; например, от 200 и более).

Формулы для вычисления границ

доверительного интервала существенно упрощаются при таких больших объемах выборок.

При больших объемах выборок n возникает простая формула для ε, на основе которой при заданном ε можно вычислить соответствующее n:

Слайд 105

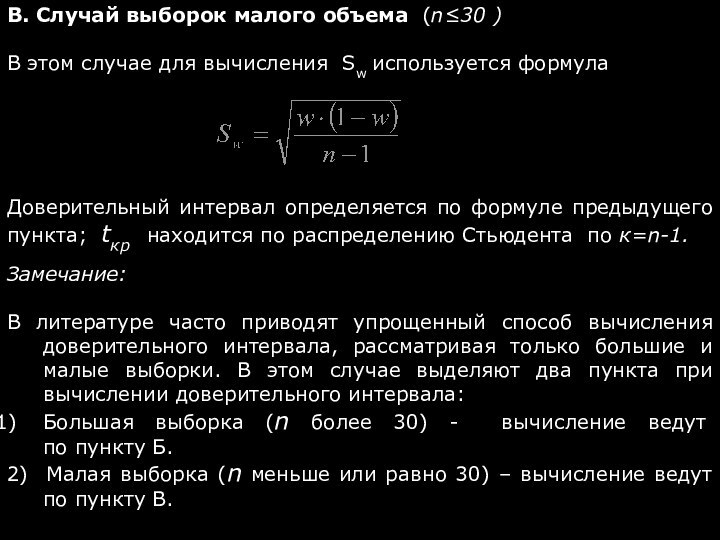

В. Случай выборок малого объема (n≤30 )

В этом

случае для вычисления Sw используется формула

Доверительный интервал определяется по

формуле предыдущего пункта; tкр находится по распределению Стьюдента по к=n-1.

Замечание:

В литературе часто приводят упрощенный способ вычисления доверительного интервала, рассматривая только большие и малые выборки. В этом случае выделяют два пункта при вычислении доверительного интервала:

Большая выборка (n более 30) - вычисление ведут по пункту Б.

2) Малая выборка (n меньше или равно 30) – вычисление ведут по пункту В.

Слайд 106

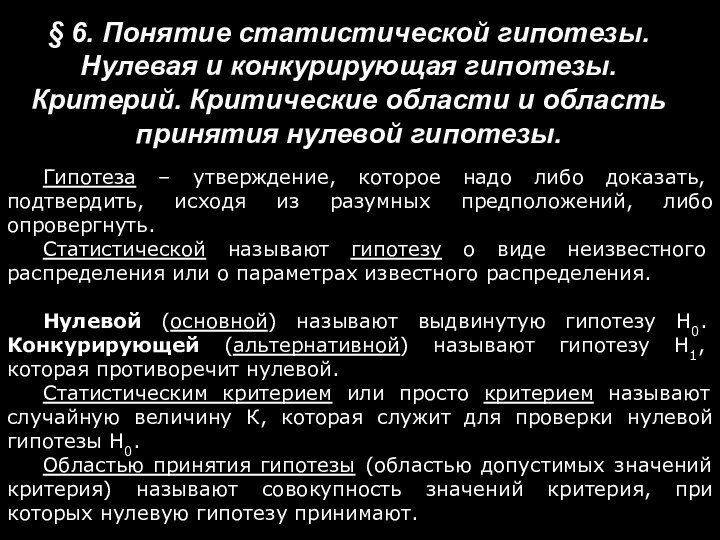

§ 6. Понятие статистической гипотезы. Нулевая и конкурирующая

гипотезы. Критерий. Критические области и область принятия нулевой гипотезы.

Гипотеза

– утверждение, которое надо либо доказать, подтвердить, исходя из разумных предположений, либо опровергнуть.

Статистической называют гипотезу о виде неизвестного распределения или о параметрах известного распределения.

Нулевой (основной) называют выдвинутую гипотезу Н0. Конкурирующей (альтернативной) называют гипотезу Н1, которая противоречит нулевой.

Статистическим критерием или просто критерием называют случайную величину К, которая служит для проверки нулевой гипотезы Н0.

Областью принятия гипотезы (областью допустимых значений критерия) называют совокупность значений критерия, при которых нулевую гипотезу принимают.

Слайд 107

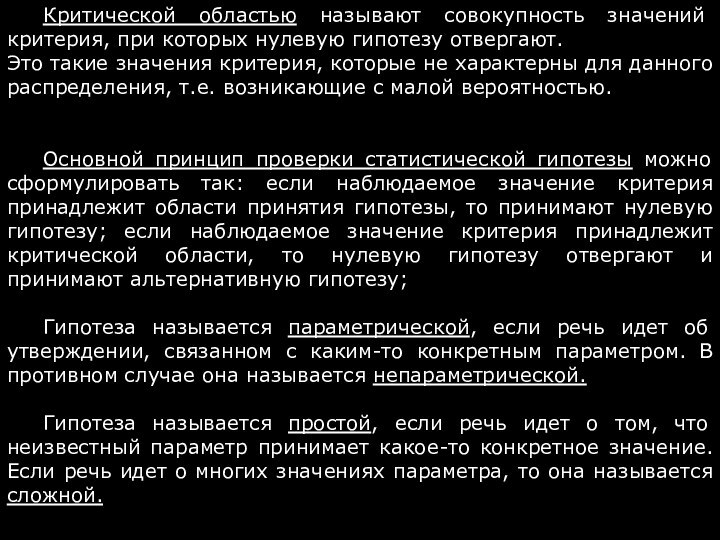

Критической областью называют совокупность значений критерия, при которых

нулевую гипотезу отвергают.

Это такие значения критерия, которые не характерны

для данного распределения, т.е. возникающие с малой вероятностью.

Основной принцип проверки статистической гипотезы можно сформулировать так: если наблюдаемое значение критерия принадлежит области принятия гипотезы, то принимают нулевую гипотезу; если наблюдаемое значение критерия принадлежит критической области, то нулевую гипотезу отвергают и принимают альтернативную гипотезу;

Гипотеза называется параметрической, если речь идет об утверждении, связанном с каким-то конкретным параметром. В противном случае она называется непараметрической.

Гипотеза называется простой, если речь идет о том, что неизвестный параметр принимает какое-то конкретное значение. Если речь идет о многих значениях параметра, то она называется сложной.

Слайд 108

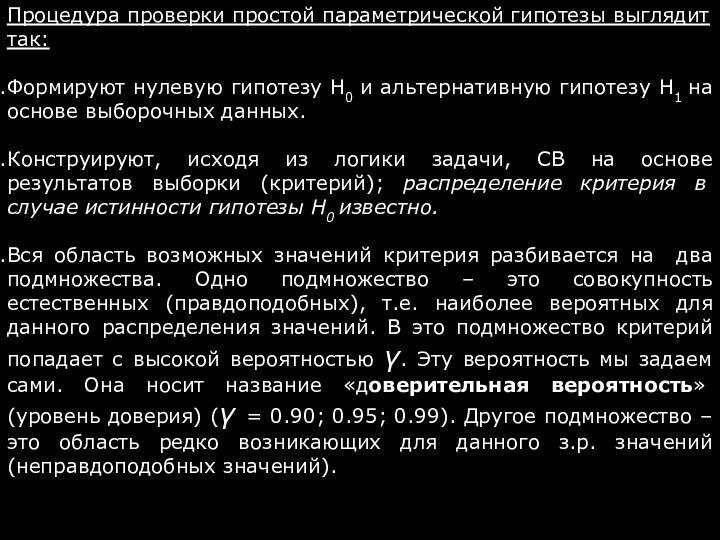

Процедура проверки простой параметрической гипотезы выглядит так:

Формируют нулевую

гипотезу Н0 и альтернативную гипотезу Н1 на основе выборочных

данных.

Конструируют, исходя из логики задачи, СВ на основе результатов выборки (критерий); распределение критерия в случае истинности гипотезы Н0 известно.

Вся область возможных значений критерия разбивается на два подмножества. Одно подмножество – это совокупность естественных (правдоподобных), т.е. наиболее вероятных для данного распределения значений. В это подмножество критерий попадает с высокой вероятностью γ. Эту вероятность мы задаем сами. Она носит название «доверительная вероятность» (уровень доверия) (γ = 0.90; 0.95; 0.99). Другое подмножество – это область редко возникающих для данного з.р. значений (неправдоподобных значений).

Слайд 109

Вероятность попадания в эту область мала и равна

α=1-γ.

α носит название «уровень значимости»(α=0.10;0.05;0.01).

4. Вычисляют значение критерия

Кнабл на основе выборочных значений изучаемого признака. Если Кнабл попадает в область правдоподобных значений, то с вероятностью γ утверждают, что гипотеза Н0 не противоречит экспериментальным данным, а поэтому принимают основную гипотезу.

Если значения Кнабл попадает в область неправдоподобных для данного з.р. значений, то отвергают гипотезу Н0 и принимают альтернативную гипотезу Н1 .

Если при проверке гипотезы Н0 эта гипотеза принимается, то этот факт не означает, что высказанное нами утверждение является единственно верным. Просто оно не противоречит имеющимся выборочным данным. Возможно, что и другое утверждение также не будет противоречить выборочным данным.

Слайд 110

6. Если наблюдаемое значение критерия Кнабл попадает в

область неестественных значений и мы, следовательно, отвергаем гипотезу Н0

и принимаем гипотезу Н1, то не можем ли мы при этом совершить ошибку - отвергнуть верную гипотезу Н0 и принять ложную гипотезу Н1? Да, можем, но вероятность этой ошибки мала; она равна величине α .

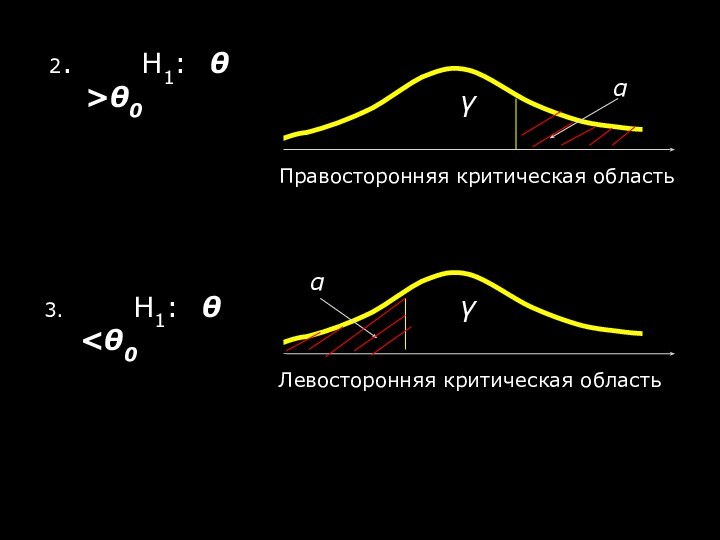

Типы альтернативных гипотез (для исходной простой параметрической гипотезы Н0 : θ = θ0)

Н1: θ ≠θ0

γ +α=1

Слайд 112

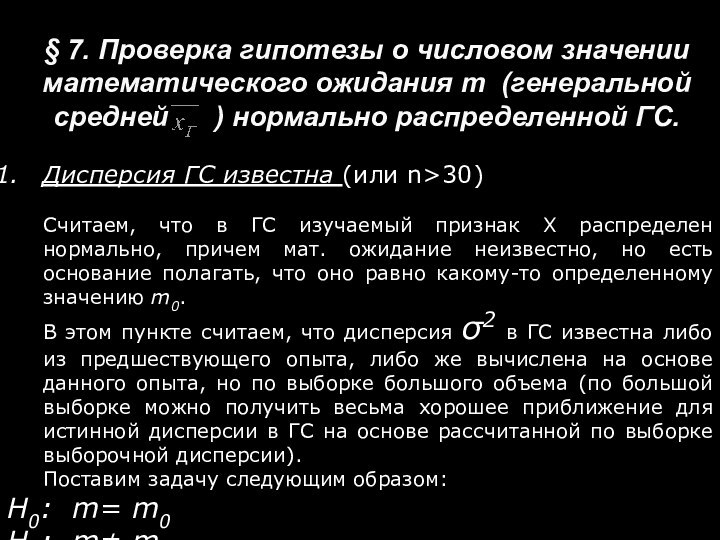

§ 7. Проверка гипотезы о числовом значении математического

ожидания m (генеральной средней ) нормально распределенной

ГС.

Дисперсия ГС известна (или n>30)

Считаем, что в ГC изучаемый признак Х распределен нормально, причем мат. ожидание неизвестно, но есть основание полагать, что оно равно какому-то определенному значению m0.

В этом пункте считаем, что дисперсия σ2 в ГС известна либо из предшествующего опыта, либо же вычислена на основе данного опыта, но по выборке большого объема (по большой выборке можно получить весьма хорошее приближение для истинной дисперсии в ГС на основе рассчитанной по выборке выборочной дисперсии).

Поставим задачу следующим образом:

Н0: m= m0

Н1: m≠ m0.

Слайд 113

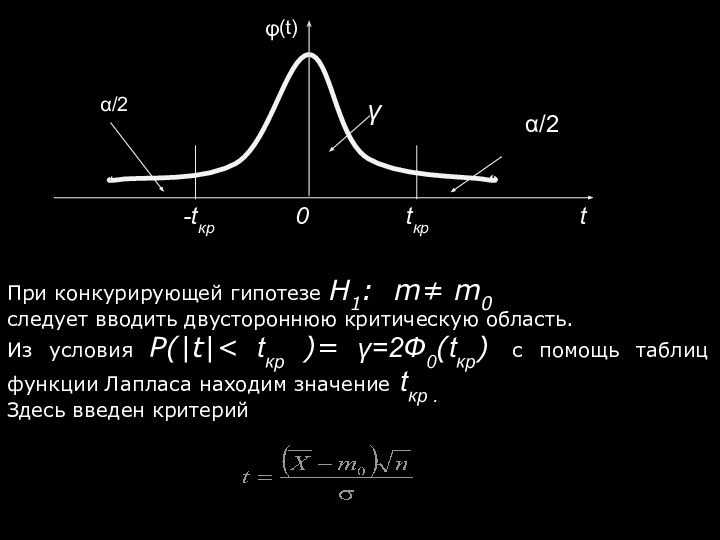

При конкурирующей гипотезе Н1: m≠ m0

следует вводить двустороннюю

критическую область.

Из условия P(|t|< tкр )= γ=2Ф0(tкр) с

помощь таблиц функции Лапласа находим значение tкр .

Здесь введен критерий

Слайд 114

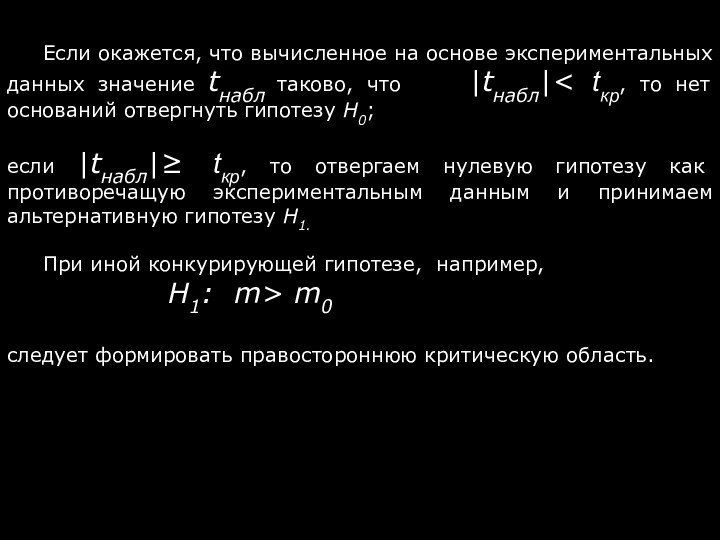

Если окажется, что вычисленное на основе экспериментальных данных

значение tнабл таково, что |tнабл|< tкр, то

нет оснований отвергнуть гипотезу Н0;

если |tнабл|≥ tкр, то отвергаем нулевую гипотезу как противоречащую экспериментальным данным и принимаем альтернативную гипотезу Н1.

При иной конкурирующей гипотезе, например,

Н1: m> m0

следует формировать правостороннюю критическую область.

Слайд 115

Если tнабл < tкр ,то принимается гипотеза Н0;

если

tнабл ≥ tкр, то отвергаем нулевую гипотезу и принимаем

альтернативную гипотезу Н1.

Слайд 116

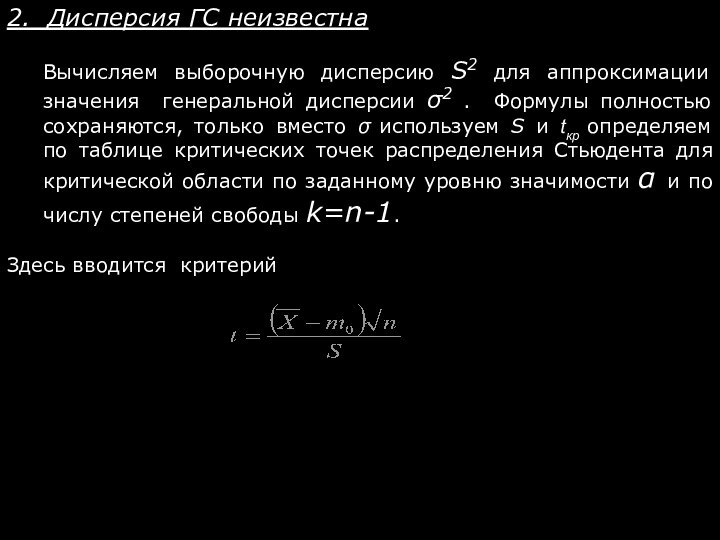

2. Дисперсия ГС неизвестна

Вычисляем выборочную дисперсию S2 для

аппроксимации значения генеральной дисперсии σ2 . Формулы полностью сохраняются,

только вместо σ используем S и tкр определяем по таблице критических точек распределения Стьюдента для критической области по заданному уровню значимости α и по числу степеней свободы k=n-1.

Здесь вводится критерий

Слайд 117

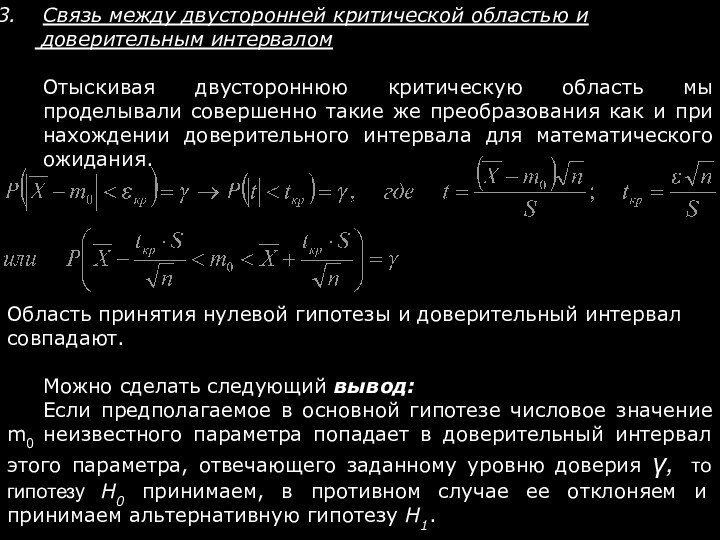

Связь между двусторонней критической областью и

доверительным интервалом

Отыскивая двустороннюю критическую область мы проделывали совершенно такие

же преобразования как и при нахождении доверительного интервала для математического ожидания.

Область принятия нулевой гипотезы и доверительный интервал совпадают.

Можно сделать следующий вывод:

Если предполагаемое в основной гипотезе числовое значение m0 неизвестного параметра попадает в доверительный интервал этого параметра, отвечающего заданному уровню доверия γ, то гипотезу Н0 принимаем, в противном случае ее отклоняем и принимаем альтернативную гипотезу Н1.

Слайд 118

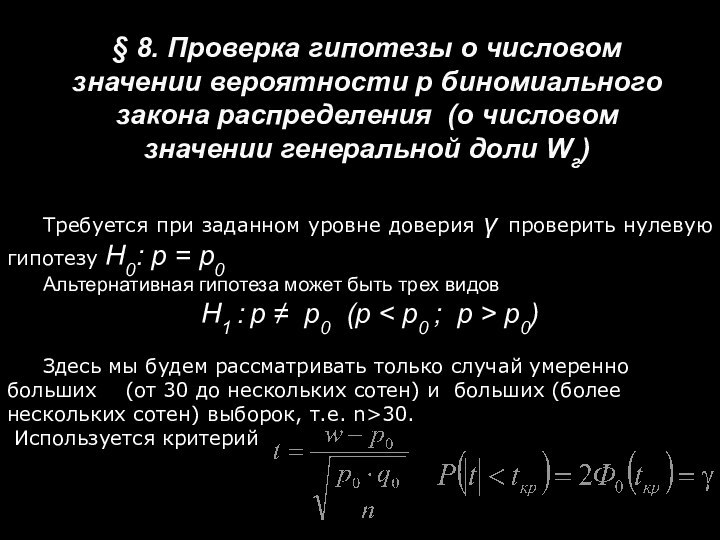

§ 8. Проверка гипотезы о числовом значении вероятности

p биномиального закона распределения (о числовом значении генеральной доли

Wг)

Требуется при заданном уровне доверия γ проверить нулевую гипотезу H0: p = p0

Альтернативная гипотеза может быть трех видов

H1 : p ≠ p0 (p < p0 ; p > p0)

Здесь мы будем рассматривать только случай умеренно больших (от 30 до нескольких сотен) и больших (более нескольких сотен) выборок, т.е. n>30.

Используется критерий

Слайд 119

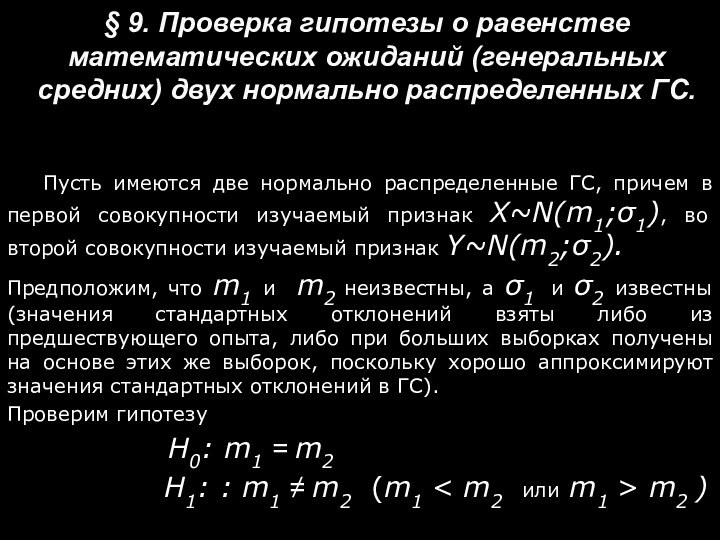

§ 9. Проверка гипотезы о равенстве математических ожиданий

(генеральных средних) двух нормально распределенных ГС.

Пусть имеются две нормально

распределенные ГС, причем в первой совокупности изучаемый признак X~N(m1;σ1), во второй совокупности изучаемый признак Y~N(m2;σ2).

Предположим, что m1 и m2 неизвестны, а σ1 и σ2 известны (значения стандартных отклонений взяты либо из предшествующего опыта, либо при больших выборках получены на основе этих же выборок, поскольку хорошо аппроксимируют значения стандартных отклонений в ГС).

Проверим гипотезу

Н0: m1 = m2

Н1: : m1 ≠ m2 (m1 < m2 или m1 > m2 )

Слайд 120

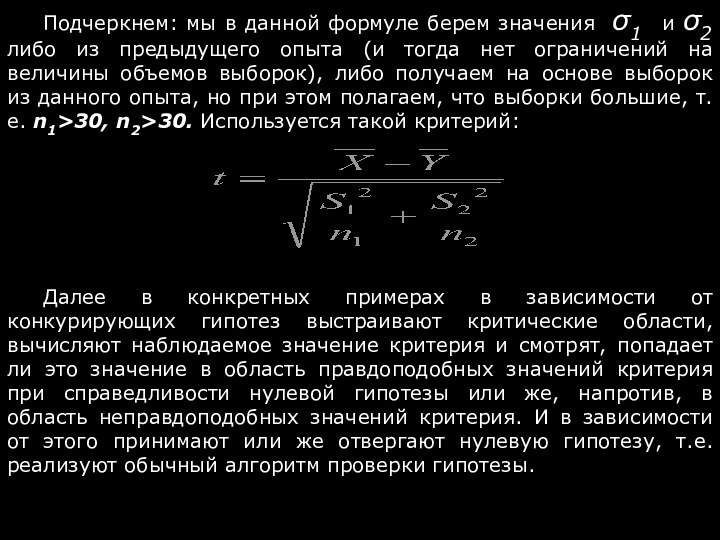

Подчеркнем: мы в данной формуле берем значения σ1

и σ2 либо из предыдущего опыта (и тогда

нет ограничений на величины объемов выборок), либо получаем на основе выборок из данного опыта, но при этом полагаем, что выборки большие, т.е. n1>30, n2>30. Используется такой критерий:

Далее в конкретных примерах в зависимости от конкурирующих гипотез выстраивают критические области, вычисляют наблюдаемое значение критерия и смотрят, попадает ли это значение в область правдоподобных значений критерия при справедливости нулевой гипотезы или же, напротив, в область неправдоподобных значений критерия. И в зависимости от этого принимают или же отвергают нулевую гипотезу, т.е. реализуют обычный алгоритм проверки гипотезы.

Слайд 121

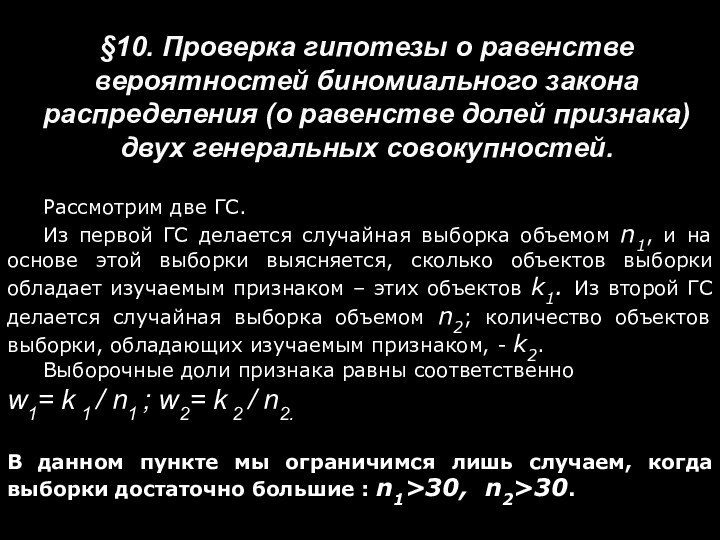

§10. Проверка гипотезы о равенстве вероятностей биномиального закона

распределения (о равенстве долей признака) двух генеральных совокупностей.

Рассмотрим две

ГС.

Из первой ГС делается случайная выборка объемом n1, и на основе этой выборки выясняется, сколько объектов выборки обладает изучаемым признаком – этих объектов k1. Из второй ГС делается случайная выборка объемом n2; количество объектов выборки, обладающих изучаемым признаком, - k2.

Выборочные доли признака равны соответственно

w1= k 1 / n1 ; w2= k 2 / n2.

В данном пункте мы ограничимся лишь случаем, когда выборки достаточно большие : n1>30, n2>30.

Слайд 122

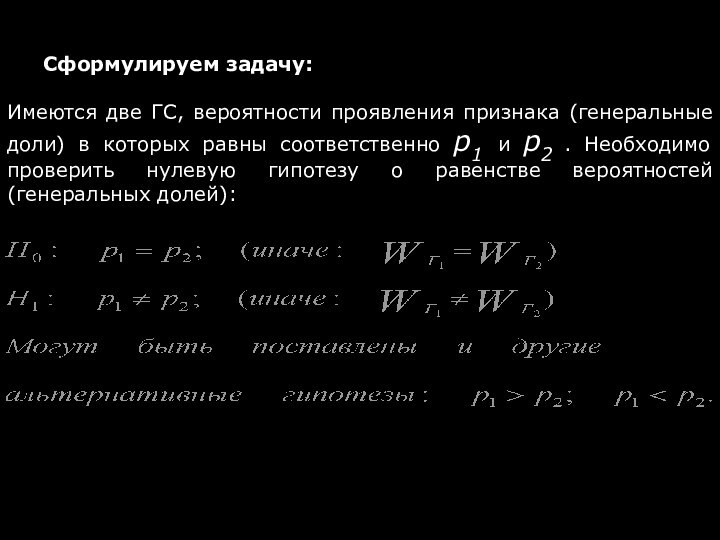

Сформулируем задачу:

Имеются две ГС, вероятности проявления признака (генеральные

доли) в которых равны соответственно p1 и p2 .

Необходимо проверить нулевую гипотезу о равенстве вероятностей (генеральных долей):

Слайд 123

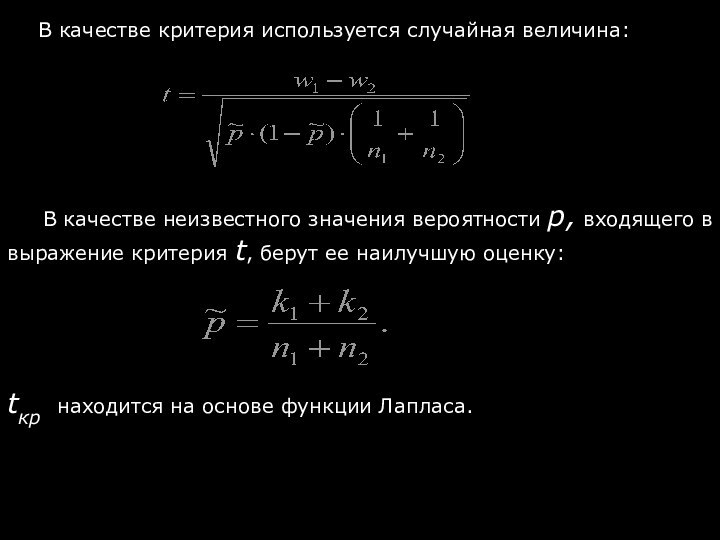

В качестве неизвестного значения вероятности р, входящего в

выражение критерия t, берут ее наилучшую оценку:

tкр находится на

основе функции Лапласа.

В качестве критерия используется случайная величина:

Слайд 124

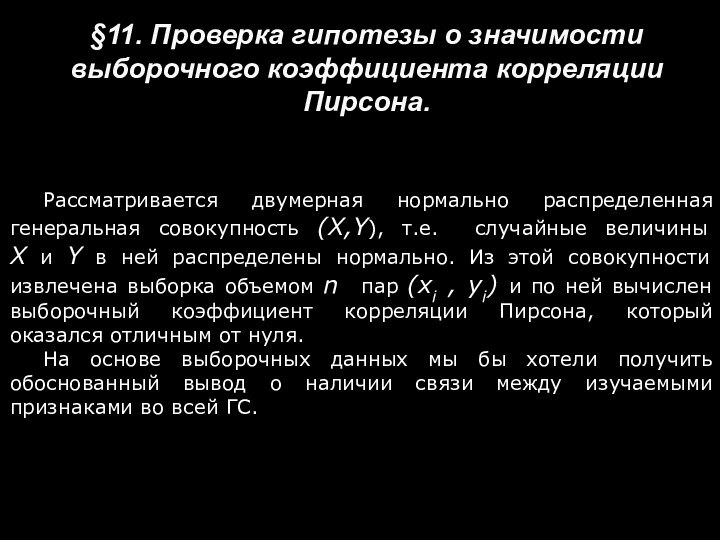

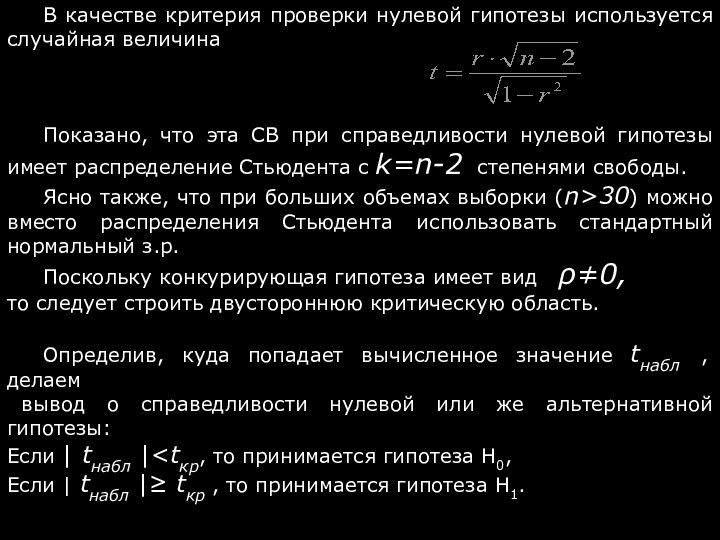

§11. Проверка гипотезы о значимости выборочного коэффициента корреляции

Пирсона.

Рассматривается двумерная нормально распределенная генеральная совокупность (X,Y), т.е. случайные

величины X и Y в ней распределены нормально. Из этой совокупности извлечена выборка объемом n пар (xi , yi) и по ней вычислен выборочный коэффициент корреляции Пирсона, который оказался отличным от нуля.

На основе выборочных данных мы бы хотели получить обоснованный вывод о наличии связи между изучаемыми признаками во всей ГС.

Слайд 125

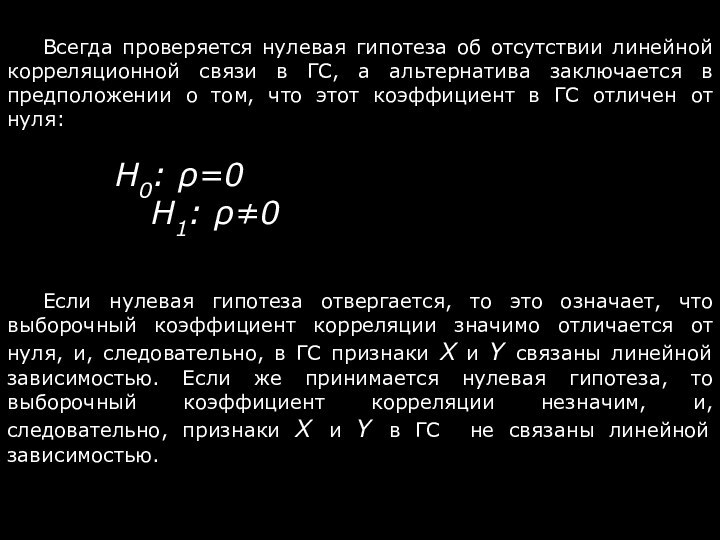

Всегда проверяется нулевая гипотеза об отсутствии линейной корреляционной

связи в ГС, а альтернатива заключается в предположении о

том, что этот коэффициент в ГС отличен от нуля:

H0: ρ=0

H1: ρ≠0

Если нулевая гипотеза отвергается, то это означает, что выборочный коэффициент корреляции значимо отличается от нуля, и, следовательно, в ГС признаки X и Y связаны линейной зависимостью. Если же принимается нулевая гипотеза, то выборочный коэффициент корреляции незначим, и, следовательно, признаки X и Y в ГС не связаны линейной зависимостью.

Слайд 126

В качестве критерия проверки нулевой гипотезы используется случайная

величина

Показано, что эта СВ при справедливости нулевой гипотезы

имеет распределение Стьюдента с k=n-2 степенями свободы.

Ясно также, что при больших объемах выборки (n>30) можно вместо распределения Стьюдента использовать стандартный нормальный з.р.

Поскольку конкурирующая гипотеза имеет вид ρ≠0,

то следует строить двустороннюю критическую область.

Определив, куда попадает вычисленное значение tнабл , делаем

вывод о справедливости нулевой или же альтернативной гипотезы:

Если | tнабл |Если | tнабл |≥ tкр , то принимается гипотеза H1.

Слайд 127

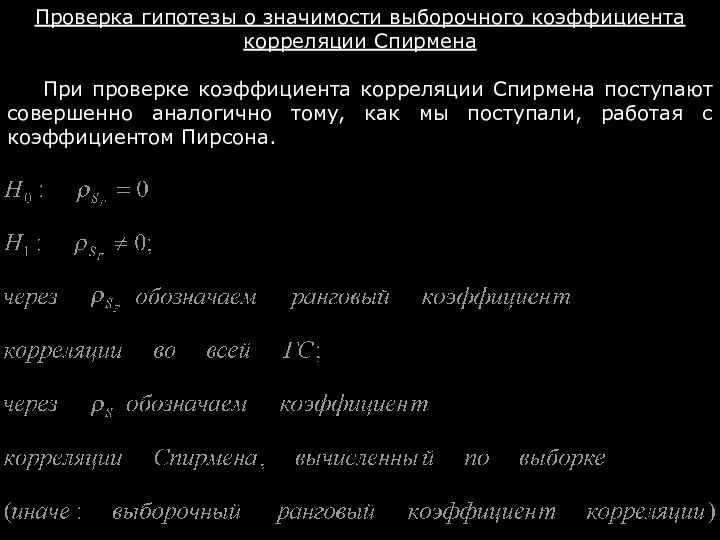

Проверка гипотезы о значимости выборочного коэффициента корреляции Спирмена

При

проверке коэффициента корреляции Спирмена поступают совершенно аналогично тому, как

мы поступали, работая с коэффициентом Пирсона.

Слайд 128

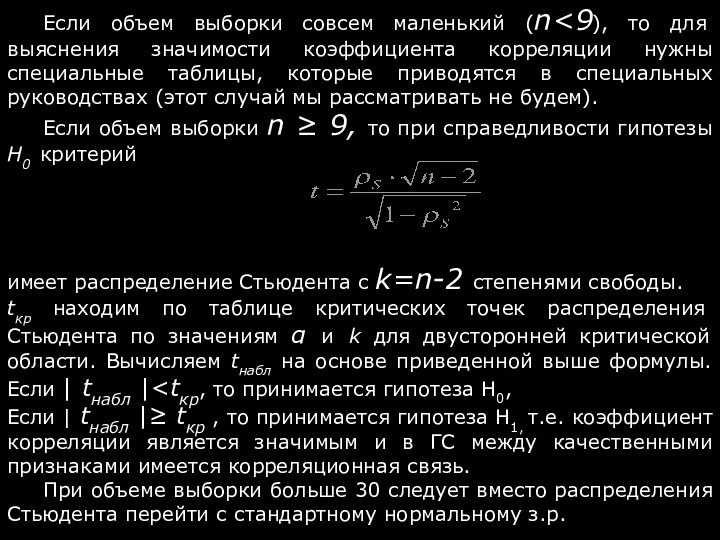

Если объем выборки совсем маленький (n

выяснения значимости коэффициента корреляции нужны специальные таблицы, которые приводятся

в специальных руководствах (этот случай мы рассматривать не будем).

Если объем выборки n ≥ 9, то при справедливости гипотезы H0 критерий

имеет распределение Стьюдента с k=n-2 степенями свободы.

tкр находим по таблице критических точек распределения Стьюдента по значениям α и k для двусторонней критической области. Вычисляем tнабл на основе приведенной выше формулы. Если | tнабл |Если | tнабл |≥ tкр , то принимается гипотеза H1, т.е. коэффициент корреляции является значимым и в ГС между качественными признаками имеется корреляционная связь.

При объеме выборки больше 30 следует вместо распределения Стьюдента перейти с стандартному нормальному з.р.

Слайд 129

Критерий знаков не связан с заданием каких-то конкретных

значений параметров распределения, и поэтому на основе этого критерия

формулируются так называемые непараметрические статистические гипотезы.

Это самый простой критерий непараметрической статистики. Простота критерия объясняется двумя причинами:

Не делается предположение о том, что ГС имеет нормальное распределение или какое-то другое распределение. Единственное предположение – распределение должно быть непрерывным.

Критерий знаков использует только знаки различий между двумя числами, а не их количественную меру. Поэтому иногда его называют «ранговый критерий проверки гипотез».

§12. Критерий знаков.

Слайд 130

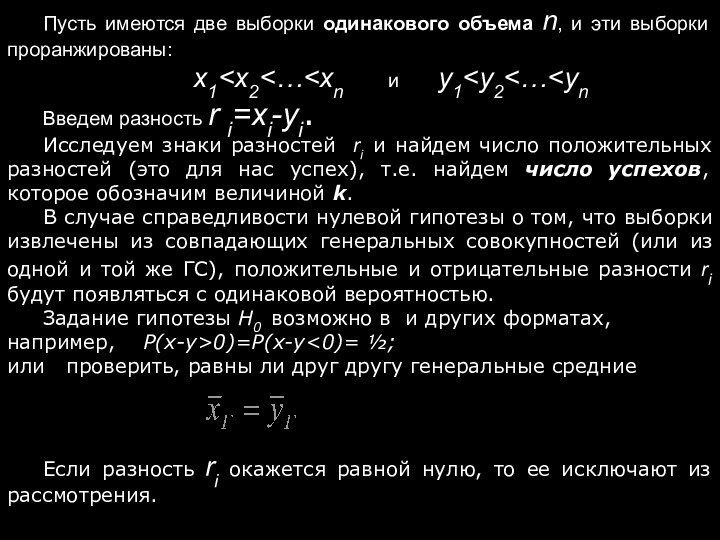

Пусть имеются две выборки одинакового объема n, и

эти выборки проранжированы:

x1 Введем разность r i=xi-yi.

Исследуем знаки разностей ri и найдем число положительных разностей (это для нас успех), т.е. найдем число успехов, которое обозначим величиной k.

В случае справедливости нулевой гипотезы о том, что выборки извлечены из совпадающих генеральных совокупностей (или из одной и той же ГС), положительные и отрицательные разности ri будут появляться с одинаковой вероятностью.

Задание гипотезы H0 возможно в и других форматах,

например, Р(x-y>0)=Р(x-y<0)= ½;

или проверить, равны ли друг другу генеральные средние

Если разность ri окажется равной нулю, то ее исключают из рассмотрения.

Слайд 131

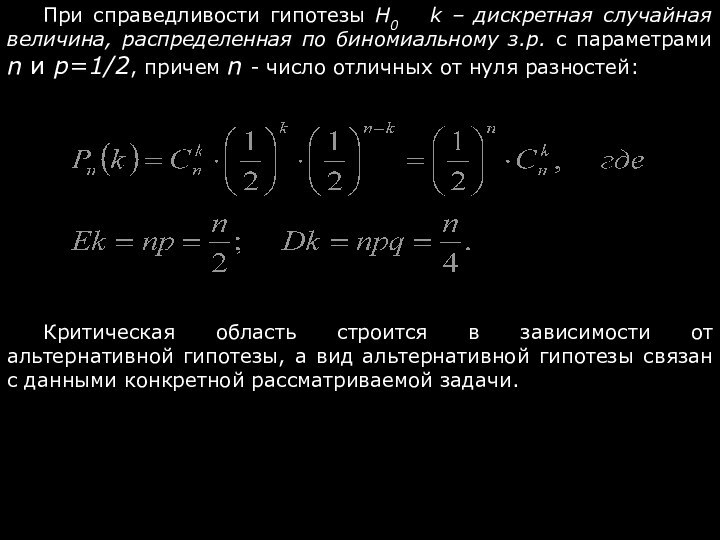

При справедливости гипотезы H0 k – дискретная

случайная величина, распределенная по биномиальному з.р. с параметрами n

и p=1/2, причем n - число отличных от нуля разностей:

Критическая область строится в зависимости от альтернативной гипотезы, а вид альтернативной гипотезы связан с данными конкретной рассматриваемой задачи.

Слайд 132

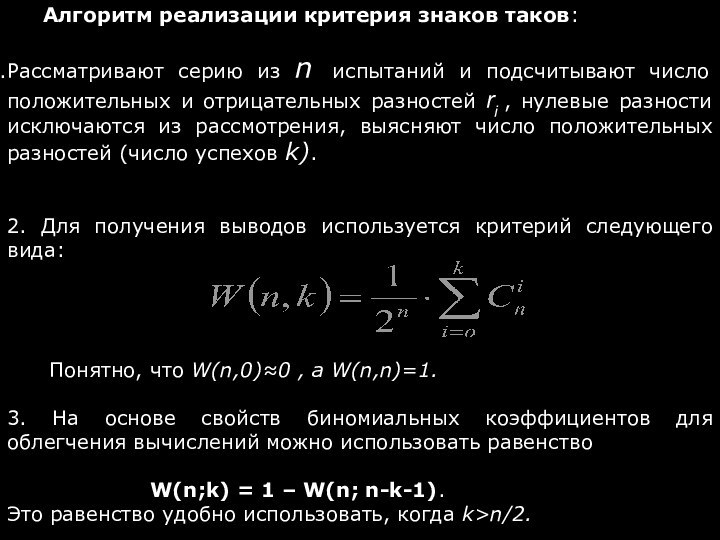

Алгоритм реализации критерия знаков таков:

Рассматривают серию из n

испытаний и подсчитывают число положительных и отрицательных разностей ri

, нулевые разности исключаются из рассмотрения, выясняют число положительных разностей (число успехов k).

2. Для получения выводов используется критерий следующего вида:

Понятно, что W(n,0)≈0 , а W(n,n)=1.

3. На основе свойств биномиальных коэффициентов для облегчения вычислений можно использовать равенство

W(n;k) = 1 – W(n; n-k-1).

Это равенство удобно использовать, когда k>n/2.

Слайд 133

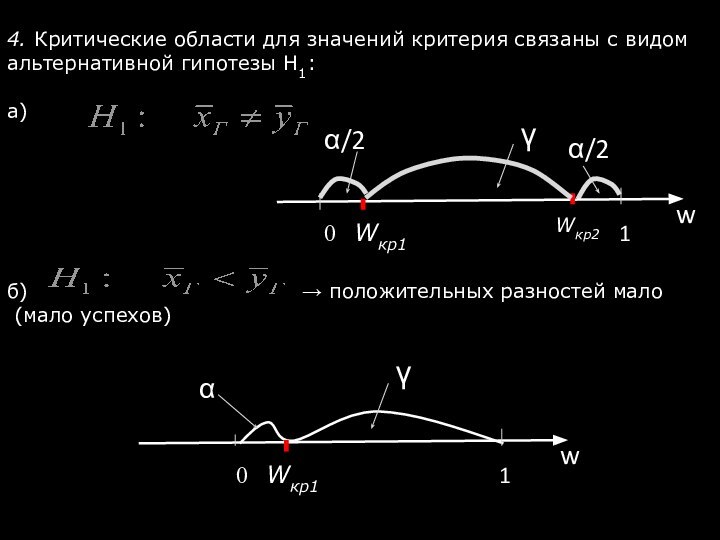

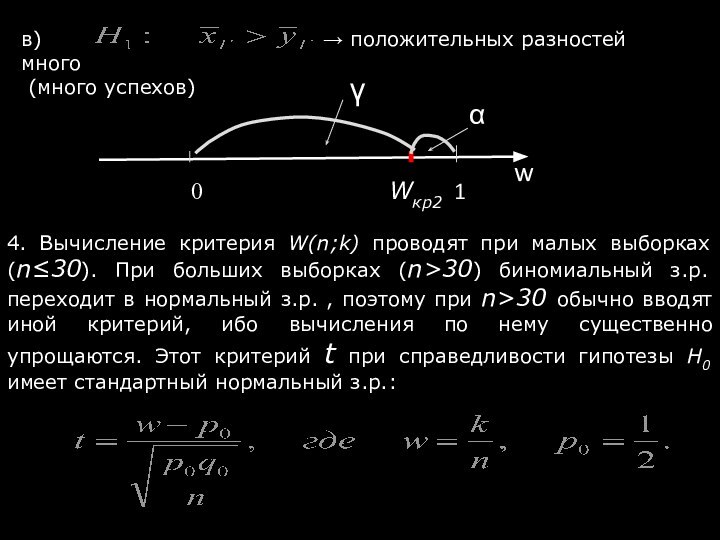

4. Критические области для значений критерия связаны с

видом альтернативной гипотезы H1:

а)

б)

→ положительных разностей мало

(мало успехов)

→ положительных разностей много

(много успехов)

4. Вычисление критерия W(n;k) проводят при малых выборках (n≤30). При больших выборках (n>30) биномиальный з.р. переходит в нормальный з.р. , поэтому при n>30 обычно вводят иной критерий, ибо вычисления по нему существенно упрощаются. Этот критерий t при справедливости гипотезы H0 имеет стандартный нормальный з.р.:

Слайд 135

§ 13. Шкалы измерений признаков.

Ранее были рассмотрены признаки,

измеряемые в количественных шкалах - в этом случае для

выяснения тесноты связи между признаками был использован коэффициент корреляции Пирсона, а также признаки, измеренные в шкале порядков - был использован коэффициент корреляции Спирмена.

До сих пор не рассматривались ситуации, когда возникает необходимость изучить связи таких признаков, как профессия, и, допустим, политические убеждения, или уровень образования и политические убеждения, и тому подобное.

Возникает новое понятие номинальных признаков и номинальных (неметрических) шкал измерений.

В этом случае объекты группируются по различным классам так, чтобы внутри класса они были идентичны по измеряемому свойству. Следует научится выявлять наличие или же отсутствие связи между номинальными признаками и научиться количественно оценивать тесноту связи между ними, если она будет выявлена.

Слайд 136

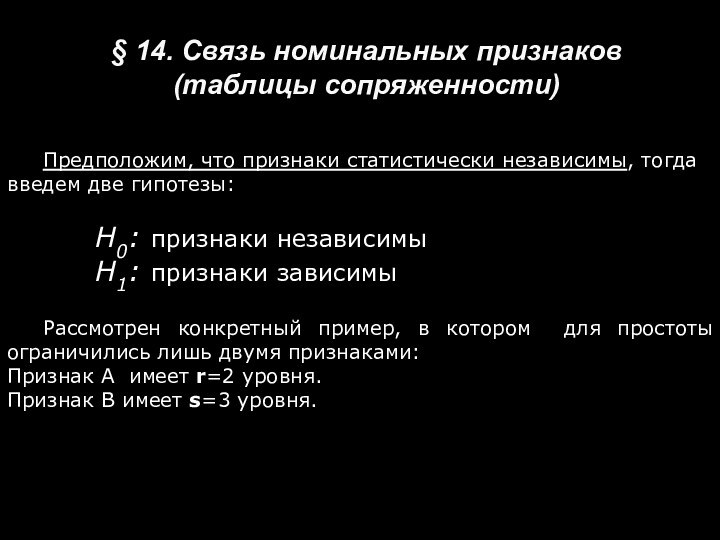

§ 14. Связь номинальных признаков

(таблицы сопряженности)

Предположим, что

признаки статистически независимы, тогда введем две гипотезы:

Н0: признаки независимы

Н1: признаки зависимы

Рассмотрен конкретный пример, в котором для простоты ограничились лишь двумя признаками:

Признак А имеет r=2 уровня.

Признак В имеет s=3 уровня.

Слайд 137

Возникла таблица 2×3.

Она называется таблицей сопряженности признаков

А и В.

Слайд 138

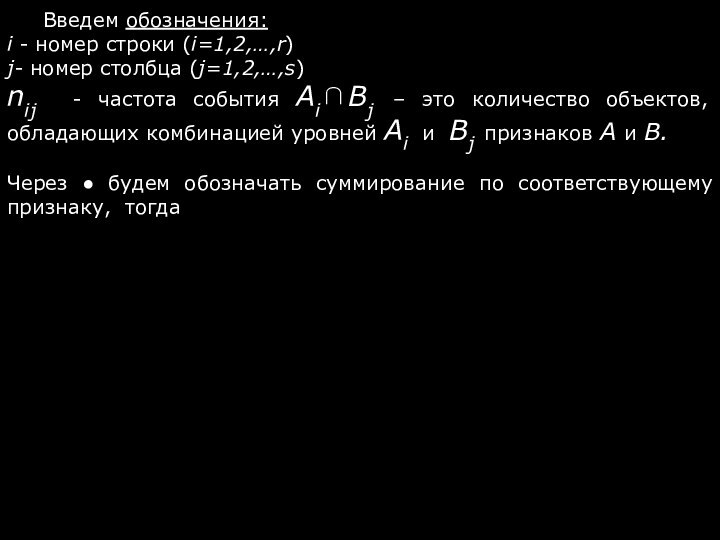

Введем обозначения:

i - номер строки (i=1,2,…,r)

j- номер столбца

(j=1,2,…,s)

nij - частота события Ai∩Bj – это количество объектов,

обладающих комбинацией уровней Ai и Bj признаков А и В.

Через ● будем обозначать суммирование по соответствующему признаку, тогда

Слайд 139

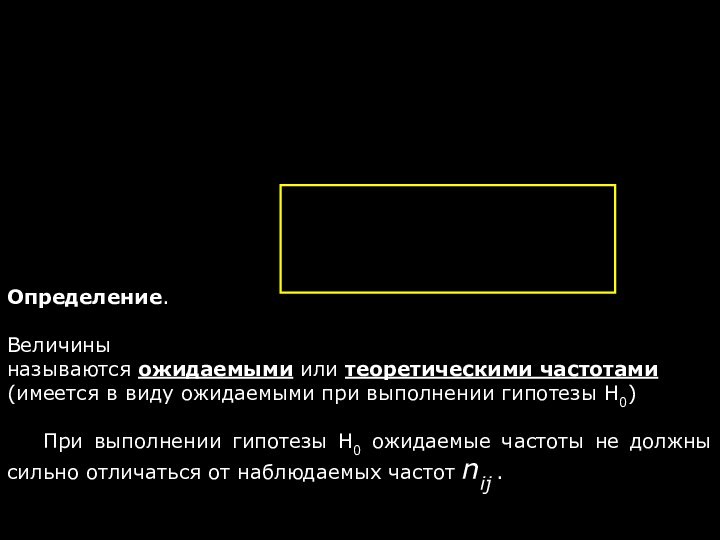

Определение.

Величины

называются ожидаемыми или теоретическими частотами (имеется в виду ожидаемыми при выполнении гипотезы H0)

При выполнении гипотезы H0 ожидаемые частоты не должны сильно отличаться от наблюдаемых частот nij .

Слайд 140

Если равенства (*) примерно выполняются, то гипотезу H0

можно признать справедливой.

Если же равенства (*) плохо выполняются, то

гипотезу H0 отвергаем, т.е. отвергаем утверждение о независимости признаков и признаем справедливой альтернативную гипотезу H1: признаки зависимые.

Сопоставим наблюдаемые Н и теоретические частоты Т:

Мера согласия опытных данных с теоретической моделью:

Суммы берется по всем ячейкам таблицы сопряженности.

Для ответа на вопрос, что такое большое значение случайной величины Х2, надо знать распределение этой СВ. Ответ на этот вопрос дает следующая теорема:

Слайд 141

Теорема (К. Пирсон, Р. Фишер):

Если справедлива гипотеза Н0,

на основе которой рассчитаны теоретические частоты Т, то при

неограниченном росте числа наблюдений n распределение СВ Х2 стремится к распределению χ- квадрат (χ2 ).

Число степеней свободы этого распределения равно разности между числом событий и числом связей между nij, заложенных в таблице сопряженности.

Число степеней свободы:

Слайд 142

Как было сказано, распределение χ2 является предельным для

СВ Х2 , поэтому использовать его как приближение для

реальных распределений Х2 можно только при большом числе наблюдений n . Считается достаточным для возможности заменить распределение СВ Х2 распределением СВ χ2 выполнение следующего ограничения: для каждой ячейки теоретические частоты должны быть не меньше 5:

Слайд 143

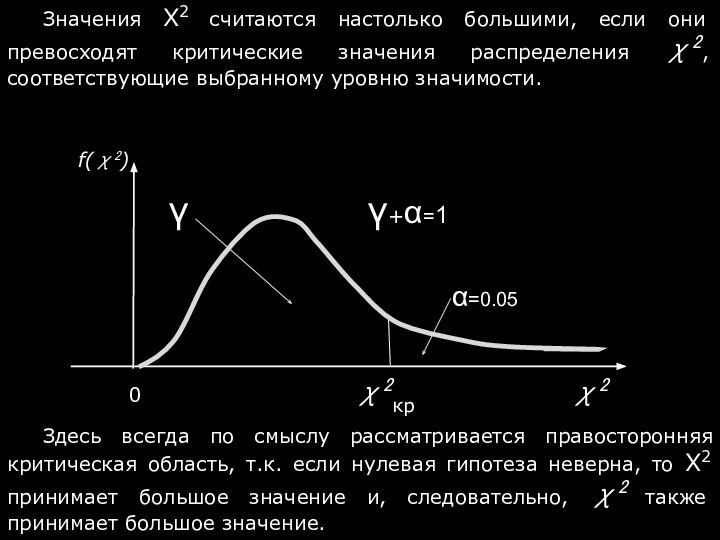

Значения Х2 считаются настолько большими, если они превосходят

критические значения распределения χ2, соответствующие выбранному уровню значимости.

Здесь всегда

по смыслу рассматривается правосторонняя критическая область, т.к. если нулевая гипотеза неверна, то Х2 принимает большое значение и, следовательно, χ2 также принимает большое значение.

Слайд 144

Коэффициенты для вычисления тесноты связи между номинальными признаками:

Коэффициент

«фи»

Коэффициент взаимной сопряженности Пирсона

Слайд 145

Благодарю за внимание! Желаю удачи в написании итоговой

контрольной работы !!!!!!!!!!!!

![Теория вероятности и статистика Непрерывные случайные величины: СВ Х имеет равномерный закон распределения на отрезке [a, b],](/img/tmb/11/1084325/485b6f5adab05bef983b99e7cb051d64-720x.jpg)