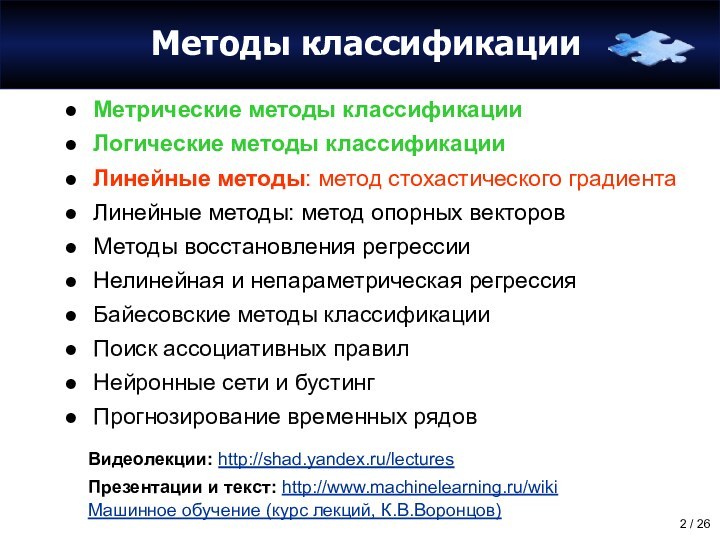

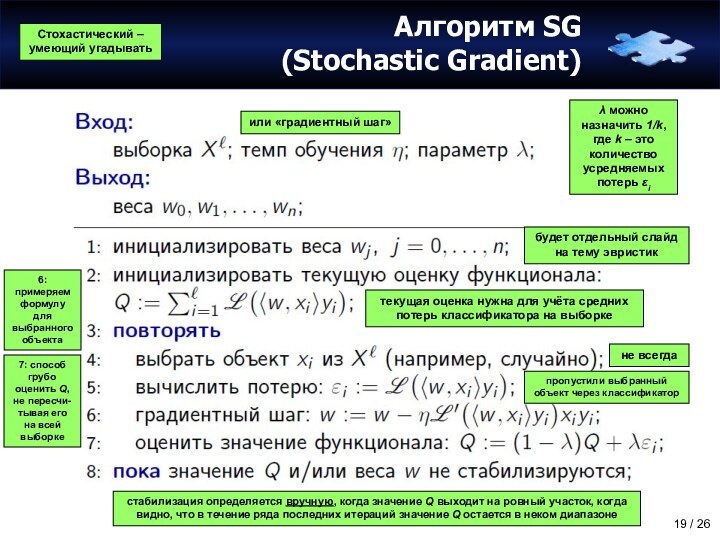

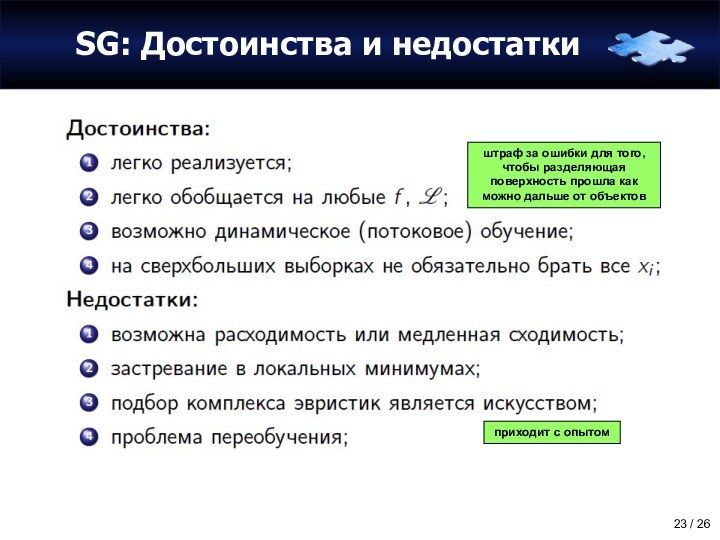

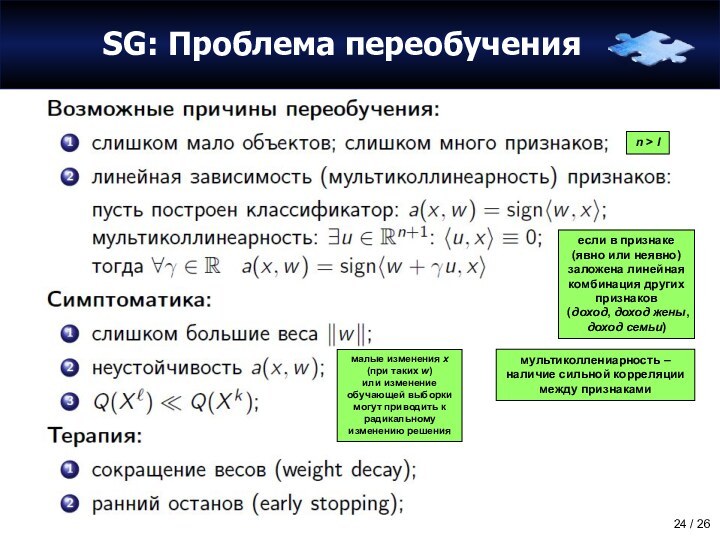

стохастического градиента

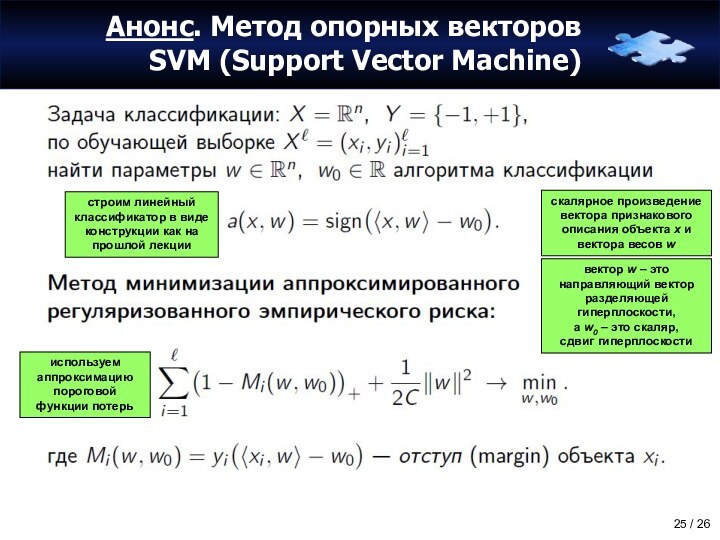

Линейные методы: метод опорных векторов

Методы восстановления регрессии

Нелинейная и

непараметрическая регрессияБайесовские методы классификации

Поиск ассоциативных правил

Нейронные сети и бустинг

Прогнозирование временных рядов

Видеолекции: http://shad.yandex.ru/lectures

Презентации и текст: http://www.machinelearning.ru/wiki

Машинное обучение (курс лекций, К.В.Воронцов)

![Линейные методы классификации (метод стохастического градиента) Анонс. Метод опорных векторов SVM (Support Vector Machine)[Mi < 0]SVMесли заменить красную](/img/tmb/15/1420095/966ce08fad476708b4698efd4726f2e5-720x.jpg)